-

集成成像是一种重要的裸眼三维(3D)显示技术[1-3],能够完整记录并全真还原场景的3D信息,近年来已成为3D显示领域的研究热点。集成成像由记录和再现两部分组成,也称为3D信息获取和显示。完整的集成成像过程首先利用微透镜阵列等光学调制元件将3D场景不同角度的信息投影到像平面,之后,利用完全可逆的光路,将投影在像平面上的信息还原为与记录场景形貌相同的3D图像。与全息3D显示、体3D等其他裸眼3D显示相比,集成成像无需相干光源,具有全视差、真彩色、轻薄化等优点,制造成本相对较低,在呈现大场景、2D/3D兼容等方面具有显著优势。集成成像能够为医疗影像、教育娱乐和军事侦查等领域提供逼真的3D图像。

集成成像3D信息获取早期多采用微透镜阵列或针孔阵列的采集方式,存在记录场景小、亮度低等问题。随着CCD、CMOS和LCD等光电器件的普及,用于记录视差信息的感光底片逐渐被替代,同时,摄像机开始在集成成像3D信息获取中得到应用,获取方式主要包括多摄像机组合和单摄像机改造等。其中,多摄像机组合主要以摄像机阵列方式呈现[4],通过严格控制摄像机的时间同步精度和相对位置精度,能够精确地从时间和空间上对3D信息进行获取和处理。单摄像机改造的示例主要为光场相机[5],通过在单个相机中引入微透镜阵列等光学调制元件,能够改变相机的成像结构,得到场景不同角度的投影信息。无论是多摄像机组合还是单摄像机改造的方式,最早都是被应用在光场采集中。由于集成成像3D信息获取本质上也是对光场的采样,因此随着集成成像技术的发展,摄像机采集方式逐渐被用来对集成成像3D信息进行获取。

按照硬件的不同,已报道的集成成像3D信息获取方式主要包括微透镜阵列、摄像机阵列和深度相机三类[6],其中微透镜阵列和摄像机阵列属于被动式获取手段,通过在图像传感器上收集调制后的目标场景自身发出或反射的光线,得到目标场景不同角度的投影信息。深度相机中大部分属于主动式获取手段,通过向目标场景投射特定的编码图案或光脉冲,计算出场景的深度信息。此外,近年来计算机技术的蓬勃发展使人们实时观看3D影像的需求愈加迫切,因此,集成成像3D信息实时获取也非常重要。

文中将对集成成像3D信息获取技术的研究进展进行系统概述,从集成成像3D信息获取原理出发,综述基于微透镜阵列、摄像机阵列以及深度相机的三类集成成像3D信息获取技术,并介绍集成成像3D信息实时获取的进展情况,最后展望集成成像3D信息获取技术未来的发展方向。

-

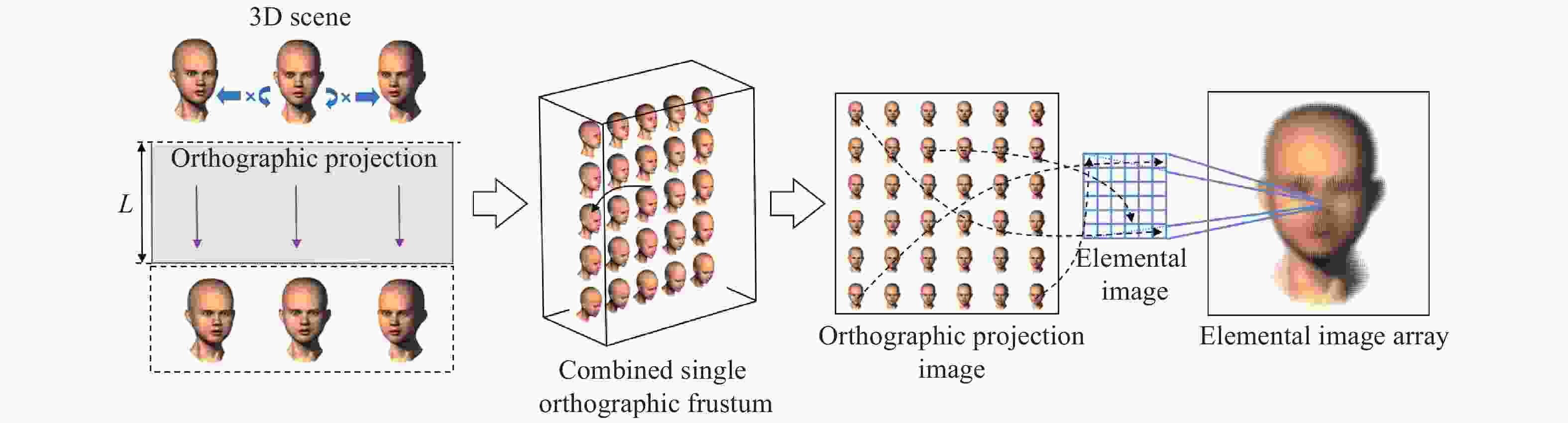

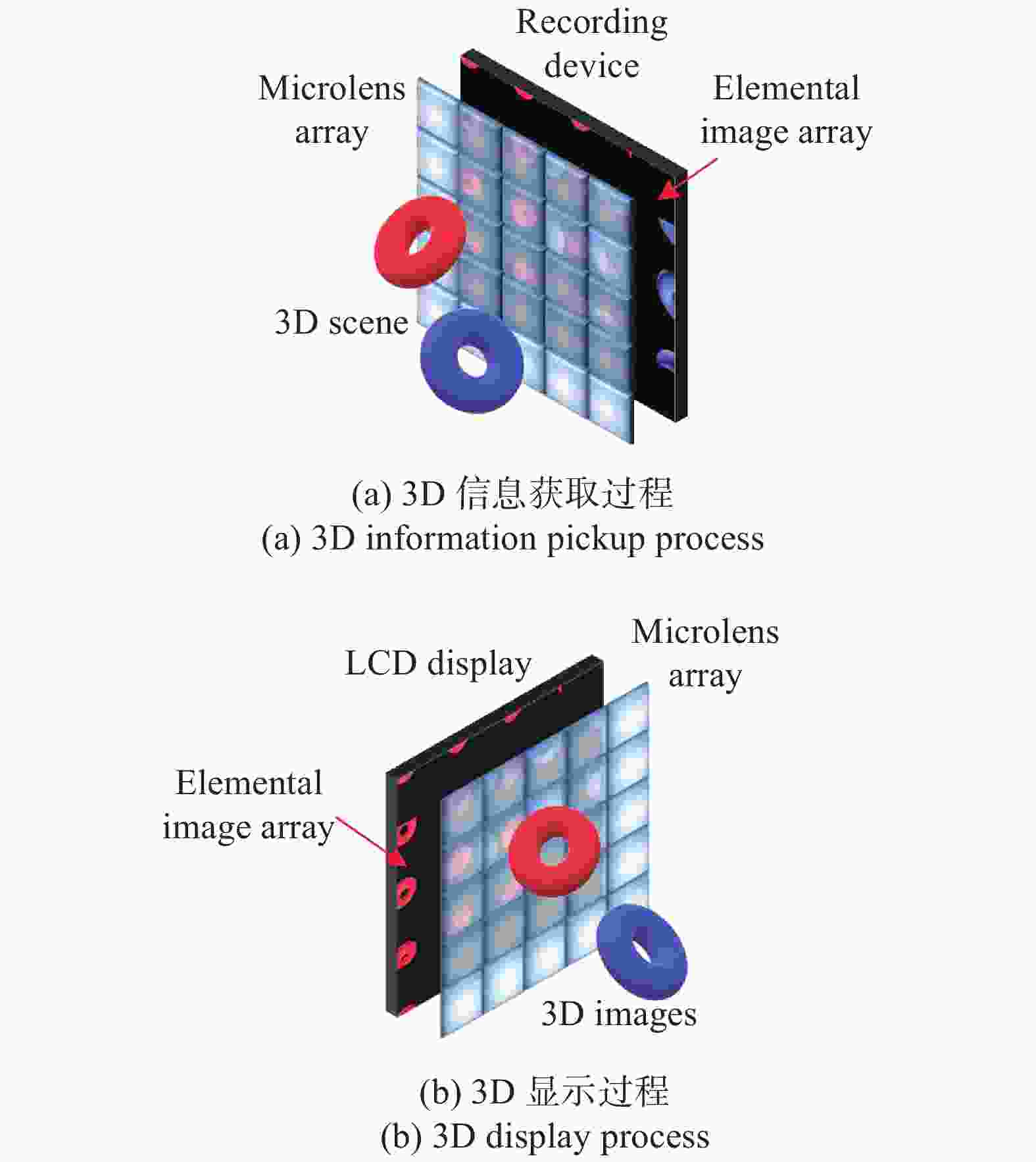

集成成像3D信息获取原理如图1(a)所示,多个透镜元在水平和竖直方向等间距排布组合成平面微透镜阵列,对目标场景不同角度信息进行获取,并将其投影到微透镜阵列的像平面上,生成微图像阵列。微透镜阵列中,每个透镜元具有独立成像的特性,能够从特定角度记录3D场景的一小部分信息,对应生成的微小像称为图像元。由于透镜元是微透镜阵列的组成单位,因而对应的图像元同样是微图像阵列的组成单位,且图像元与透镜元的排布方式完全相同。通过对3D信息的获取,3D场景中的任意离散物点被多个透镜元同时记录,并以同名点形式存储在微图像阵列中。

图 1 集成成像3D信息获取与显示过程示意图

Figure 1. Schematic of integral imaging 3D information acquirement and display processes

获取过程得到的微图像阵列将用于集成成像3D显示,对应重建出与记录3D场景相同的3D图像,如图1(b)所示。显示过程根据光路可逆原理,微透镜阵列把微图像阵列中所有图像元像素发出的光线聚集还原,在微透镜阵列前后方还原出具有水平和垂直视差的3D图像。

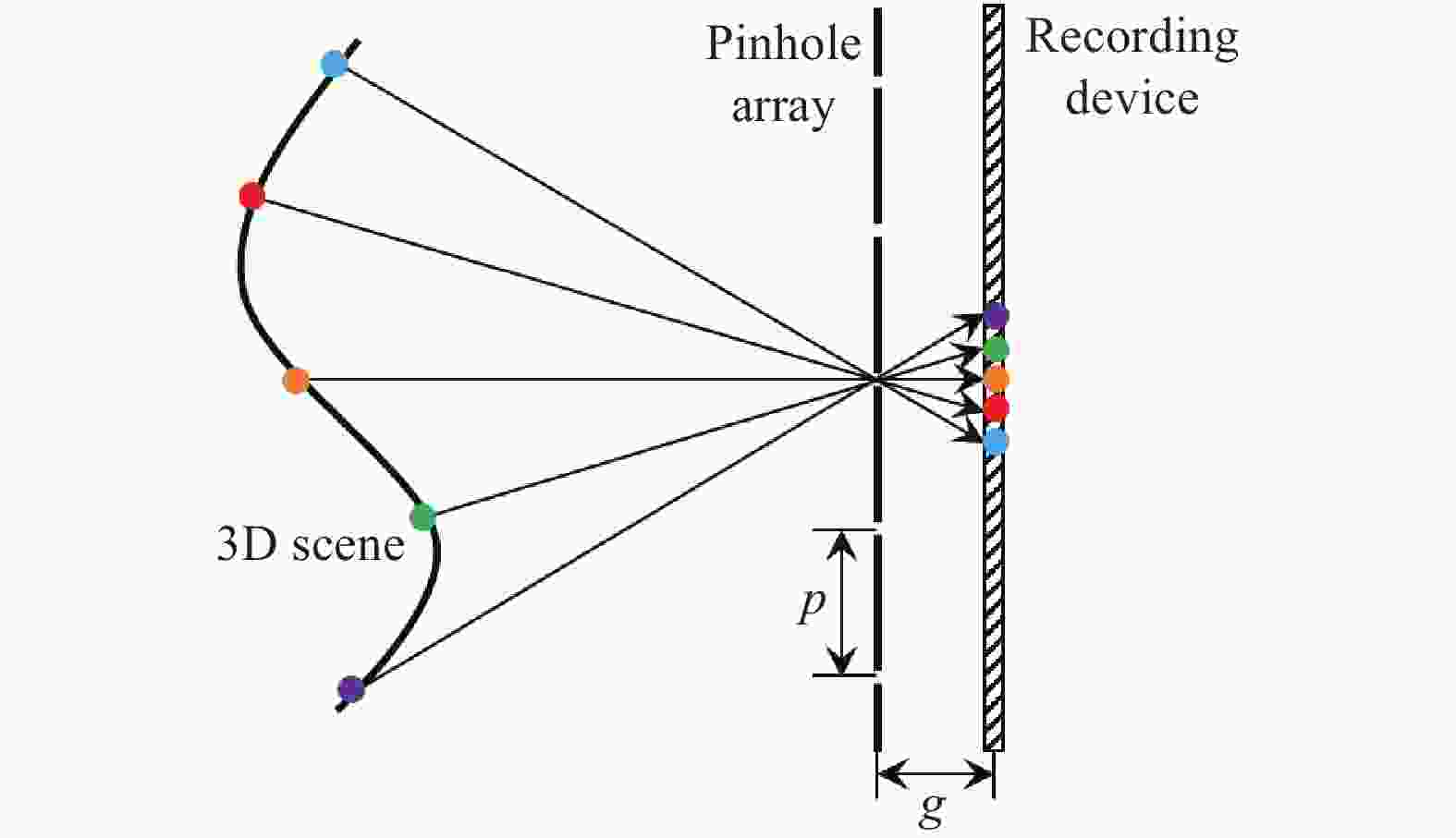

集成成像3D信息获取的核心是将空间坐标系下3D物点坐标经一系列几何变换转换为微图像阵列坐标系上的2D坐标,完成3D物点的投影变换。微透镜阵列中,每个透镜元具有独立的投影中心,其成像满足透视投影变换关系。若将透镜元的成像过程简化为针孔模型,此时透镜元的投影中心被针孔替代,微透镜阵列简化为针孔阵列,如图2所示。从光场角度分析,针孔阵列平面与图像传感器平面构成了表征采样光场的两个平面。图像传感器上每一点对应于经过该点和相应针孔的一条光线,即原始光场的一个采样,该采样不仅记录了光线的位置分布,还记录了光线的方向信息。相应地,每个图像元的像点对应于经过同一针孔的一组光线,即采样光场的一组分量。该分量对应于以该针孔为投影中心对3D场景的透视投影。

-

自1908年Lippmann首次提出集成成像以来[1],主要采用微透镜阵列对场景的3D信息进行获取,此类方法简单且易于实现,采用单个图像传感器即可接收3D信息。但是,受视场、成像分辨率、串扰以及微透镜阵列制造工艺等限制,获取的微图像阵列质量不高,且视差较小。同时,采用微透镜阵列直接拍摄存在深度反转的问题。

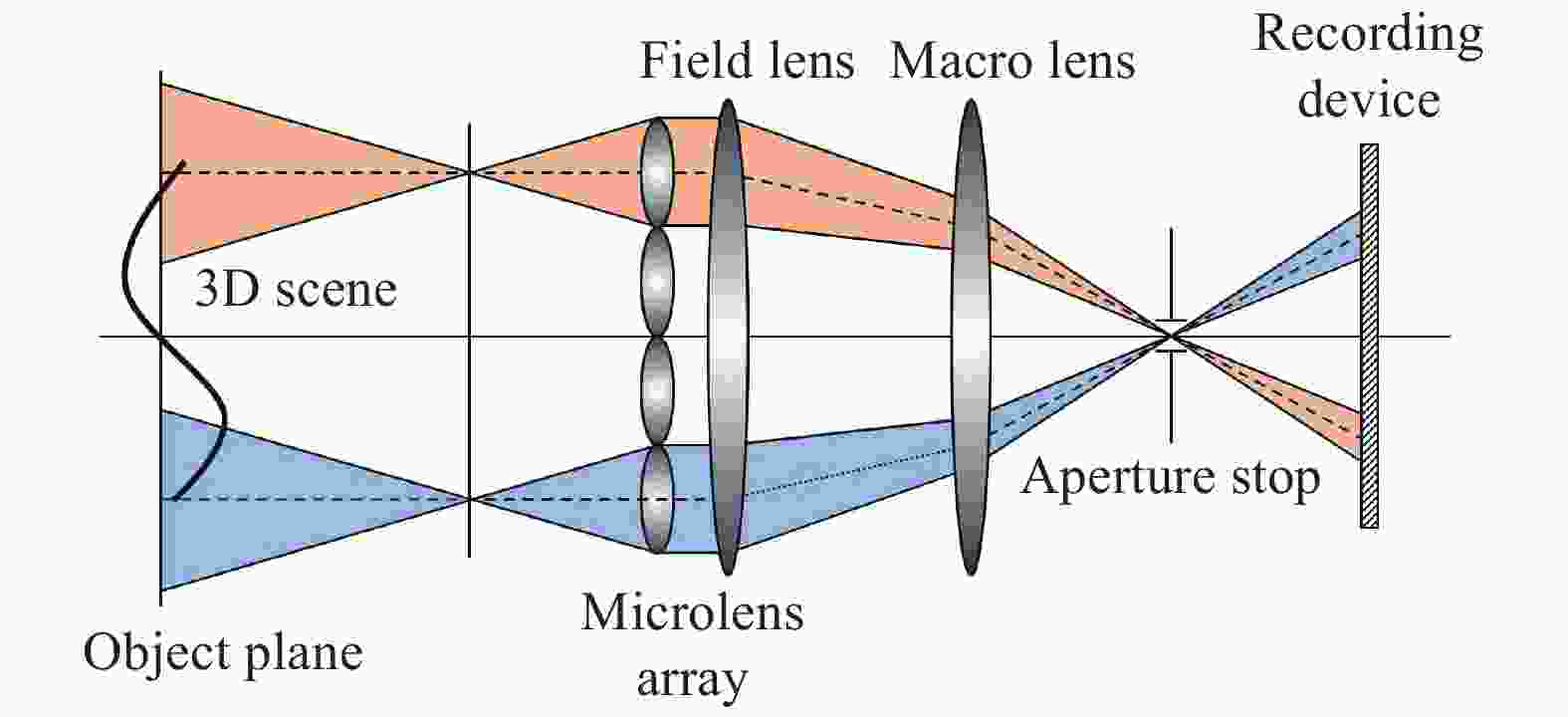

传统的微透镜阵列仅适用于小尺寸的3D近景采集,当3D场景范围较大时,会造成相邻图像元部分像素重叠,使得再现的3D图像产生串扰。为解决该问题,常用的一种方法是在微透镜阵列和图像传感器之间增加远心透镜系统[7],如图3所示,通过调整孔径光阑的尺寸,可以有效减小相邻图像元之间的重叠,使得图像元大小与透镜元保持一致。该方法得到的32×27个图像元之间的重叠和平移程度相比传统方法有明显改善。除此之外,采用渐变折射率透镜阵列[8]、4f光学系统[9]均可以在一定程度上减小3D图像的串扰。

图 3 基于远心透镜系统的3D信息获取示意图

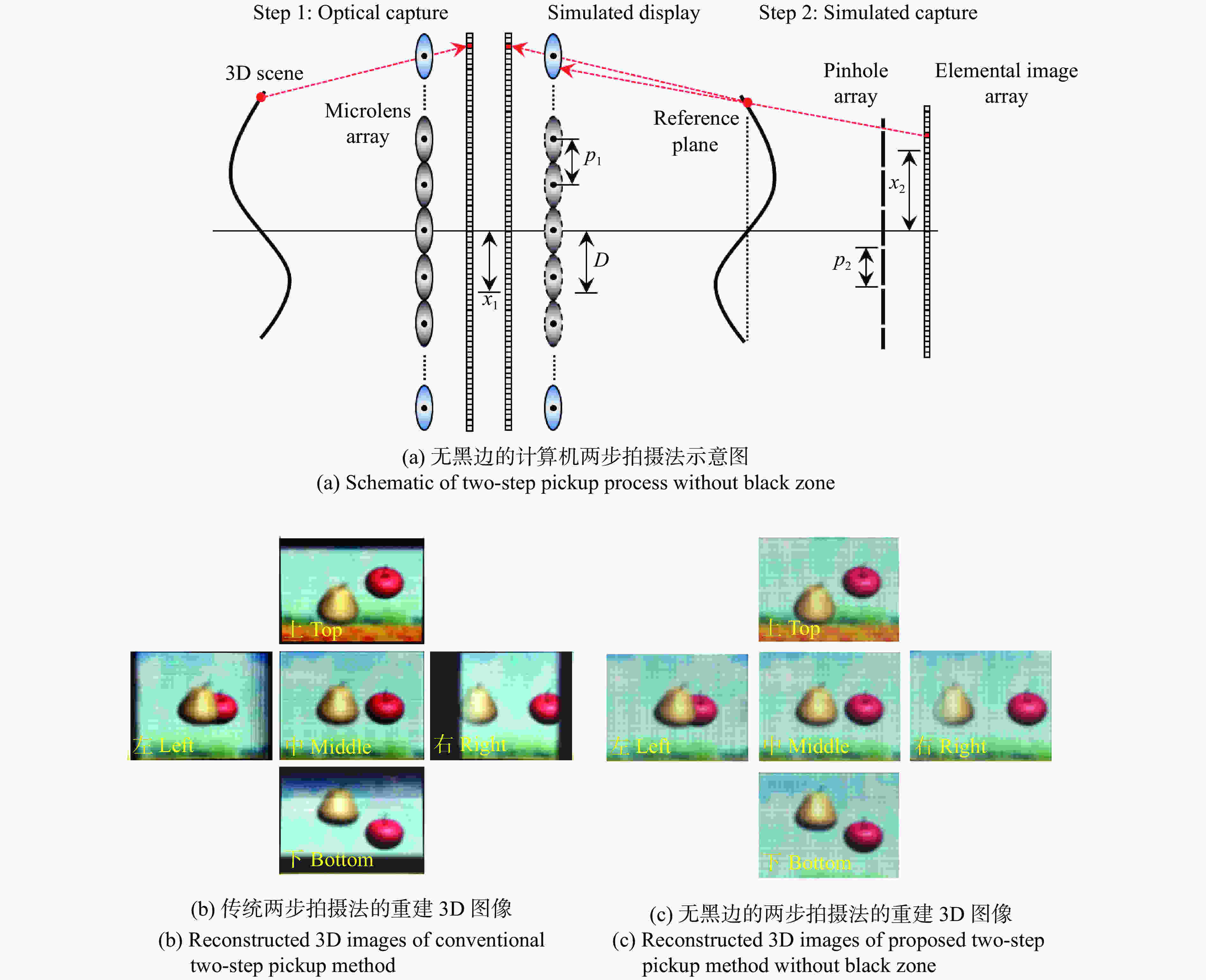

Figure 3. Schematic of 3D information acquirement based on telecentric relay system

采用微透镜阵列进行集成成像3D信息获取还存在深度反转的问题。深度反转产生的原因在于微透镜阵列的采集方向与3D显示时观看者的观看方向相反,而集成成像的3D信息获取和3D显示过程光路又完全可逆。最初解决深度问题的方法是两步拍摄法[10-11],将重建的3D图像重新作为物,利用参数相同的微透镜阵列进行二次获取,得到具有正确深度关系的微图像阵列。但该方法最大的问题是3D图像的分辨率和亮度下降严重,衍射效应明显。将每个图像元绕其中心旋转180°也可以解决深度反转问题[12],但重建的3D图像为虚像,仅能凹进显示屏中。在计算机中完成二次获取是近年来解决深度反转问题的常用手段[13-17],通过在计算机中设置虚拟针孔阵列,利用像素映射算法完成虚拟第一次显示和第二次获取,可以实现正确深度的3D信息获取。基于计算机的两步拍摄能够生成任意参数的微图像阵列,适用于多种参数的集成成像3D显示器。同时,大深度范围场景记录时的像素映射误差可通过设置多个参考平面或移动透镜阵列解决[14, 17]。王琼华团队也提出了无黑边的计算机两步拍摄法[18],如图4(a)所示,通过增加第一步3D获取时的图像元和透镜元数目,使得在计算机中进行第二次获取时,图像元像素都能记录场景的3D信息,从而有效避免了传统像素映射存在的黑边问题。图4(b)和4(c)为传统与无黑边的两步拍摄法的重建3D图像对比图。可以看出,传统两步拍摄法重建的3D图像除中心视图外都出现了严重的黑边现象,且部分3D图像被黑边遮挡,影响了3D观看效果。而改进的两步拍摄法中,3D图像清晰可见,消除了黑边现象。

图 4 无黑边的计算机两步拍摄法示意图及实验结果

Figure 4. Schematic and experimental results of two-step pickup method without black zone

除两步拍摄法外,单次拍摄同样可以校正深度[19],但需要先使用单个大口径透镜将3D物体成像在微透镜阵列后方,使得微透镜阵列对虚像进行记录,之后,经过图像元绕中心的旋转,得到正确深度的微图像阵列;或者使用渐变折射率透镜阵列[8]和负透镜阵列[20]对3D物体进行记录,但这些透镜阵列的生产工艺复杂,制作成本较高。

近年来,一些新型透镜阵列被用来对目标场景的3D信息进行获取,如液晶微透镜阵列[21]、振幅可调的微透镜阵列[22-24]和偏移透镜阵列[25]等。其中,液晶微透镜阵列具有焦距可调特性,通过对液晶微透镜阵列施加1.2~2.6 V范围内的不同电压,可将焦距调节在2~0.5 mm范围内,从而改变集成成像3D获取过程的视场角,范围为3°~12°,以适应不同的3D显示参数。基于液晶微透镜阵列的3D信息获取无需机械调节,操作简单,但是受制备工艺限制,液晶微透镜阵列的尺寸无法做大。

光场相机也可以被用来获取远场集成成像3D信息[26],但原始的光场图像数据无法直接作为微图像阵列进行集成成像3D显示,需要进行裁剪、缩放等处理。

-

为规避微透镜阵列带来的深度反转、串扰、视场小、获取分辨率低等限制,基于摄像机阵列的集成成像3D信息获取技术逐渐兴起,并已成为最常用的技术手段之一。其中代表性的技术为合成孔径集成成像[27]。合成孔径集成成像采用多个摄像机组成的矩阵式摄像机阵列或单个摄像机在二维方向上的等间隔扫描对3D场景进行拍摄,具有成像孔径大、采集视场范围大、分辨率高以及结构灵活的优点,适用于远距离3D场景信息的获取,并能大幅提升再现3D图像的分辨率。

在扫描式拍摄中,单个摄像机沿与光轴垂直的水平和竖直方向进行等间距移动,通过多次拍摄得到不同视角的视差图像。每个摄像机对单个透镜元进行模拟,摄像机平移的次数与透镜元个数相等,因此图像元分辨率大大增加。但是,该方法仅限于静态场景的3D信息获取,同时受平移台尺寸的限制,视差图像数目和视差大小有限。此外,由于本质上还是微透镜阵列的采集方式,扫描式的3D信息获取方法依然存在深度反转问题。

为克服上述问题,矩阵式采集逐渐发展起来。美国麻省理工大学搭建的8×8摄像机阵列[4]以及斯坦福大学搭建的高性能摄像机阵列[28]都能够对各摄像机姿态进行独立调节,并实现对四维光场的采集和处理。日本东京大学搭建的3D电视直播系统动态获取了8×8个分辨率为320×240的视频数据[29],并以30 帧/s的帧率生成微图像阵列进行集成成像3D显示。受当时摄像机分辨率等因素的影响,获取的微图像阵列质量普遍不高。

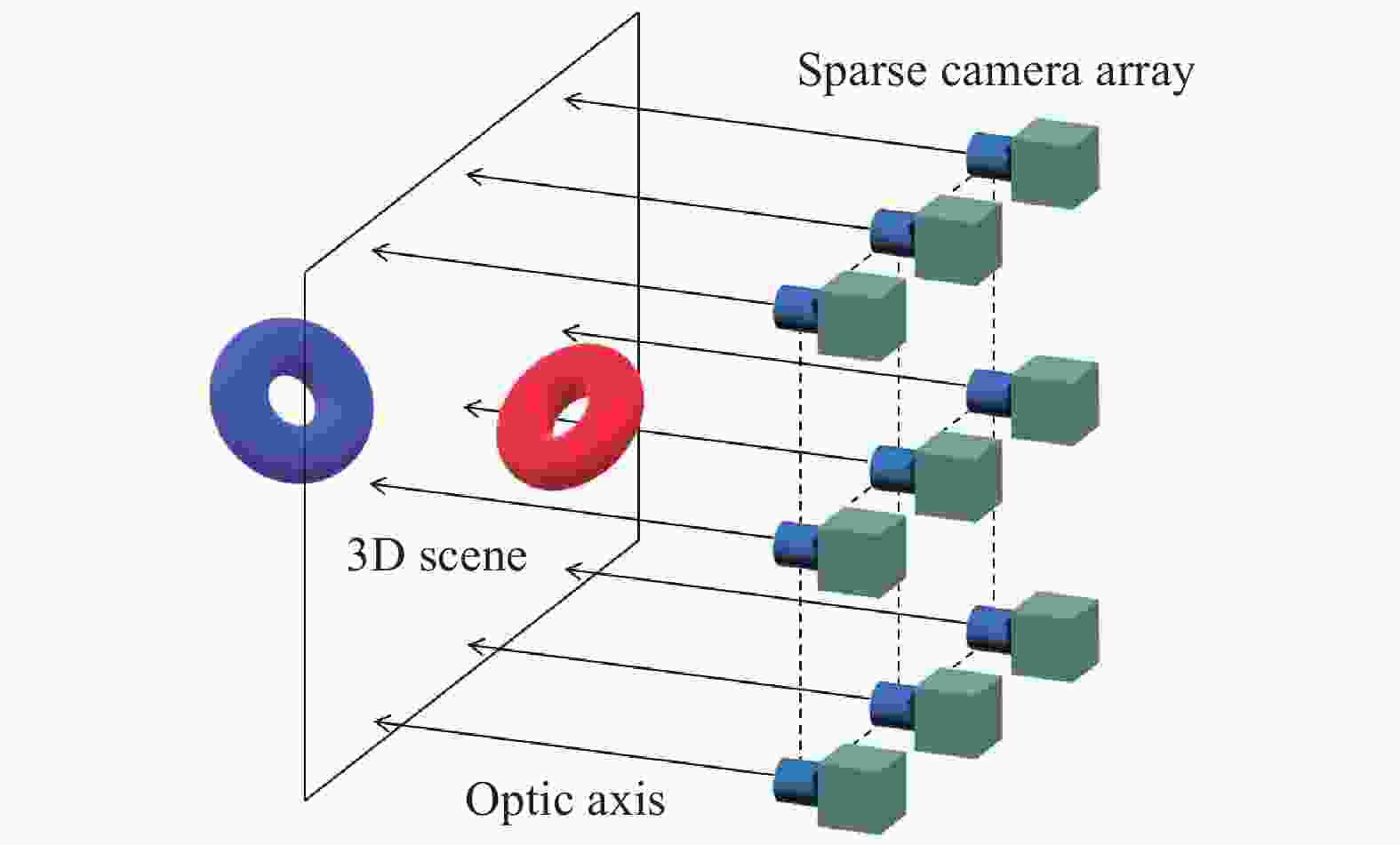

摄像机阵列的采集方式可以克服微透镜阵列采集带来的深度反转问题。王琼华团队提出了基于稀疏摄像机阵列的集成成像3D信息获取方法[30],如图5所示。该方法采用远少于图像元数量的45×44个摄像机组成稀疏摄像机阵列对目标场景进行采集,简化了3D信息获取过程,获得的视差图像经过平移、剪切和像素映射,能够得到与传统微透镜阵列3D信息获取方法结果相同的微图像阵列,分辨率达6 000×5 400。

2018年,王琼华团队搭建了基于8×8网络摄像机阵列的集成成像3D实时获取系统[31],实现了3 840×2 160分辨率的3D视频的实时渲染和显示,如图6所示。系统将8×8网络摄像机阵列作为3D视频采集设备,通过实时解压和编码,在GPU中实现了64路视频的并行几何空间校正和颜色变换,进而合成了集成成像3D视频。在几何校正方面,王琼华团队提出了基于平面视差的摄像机阵列标定方法[32],利用特定角点的棋盘格标定板图像作为平面视差,通过计算每个摄像机对应的单应性变换矩阵,实现了每个摄像机在物理上的校正和数学上的对齐,克服了摄像机位姿难以调节、不同摄像机极线非对齐以及视差串扰的问题。

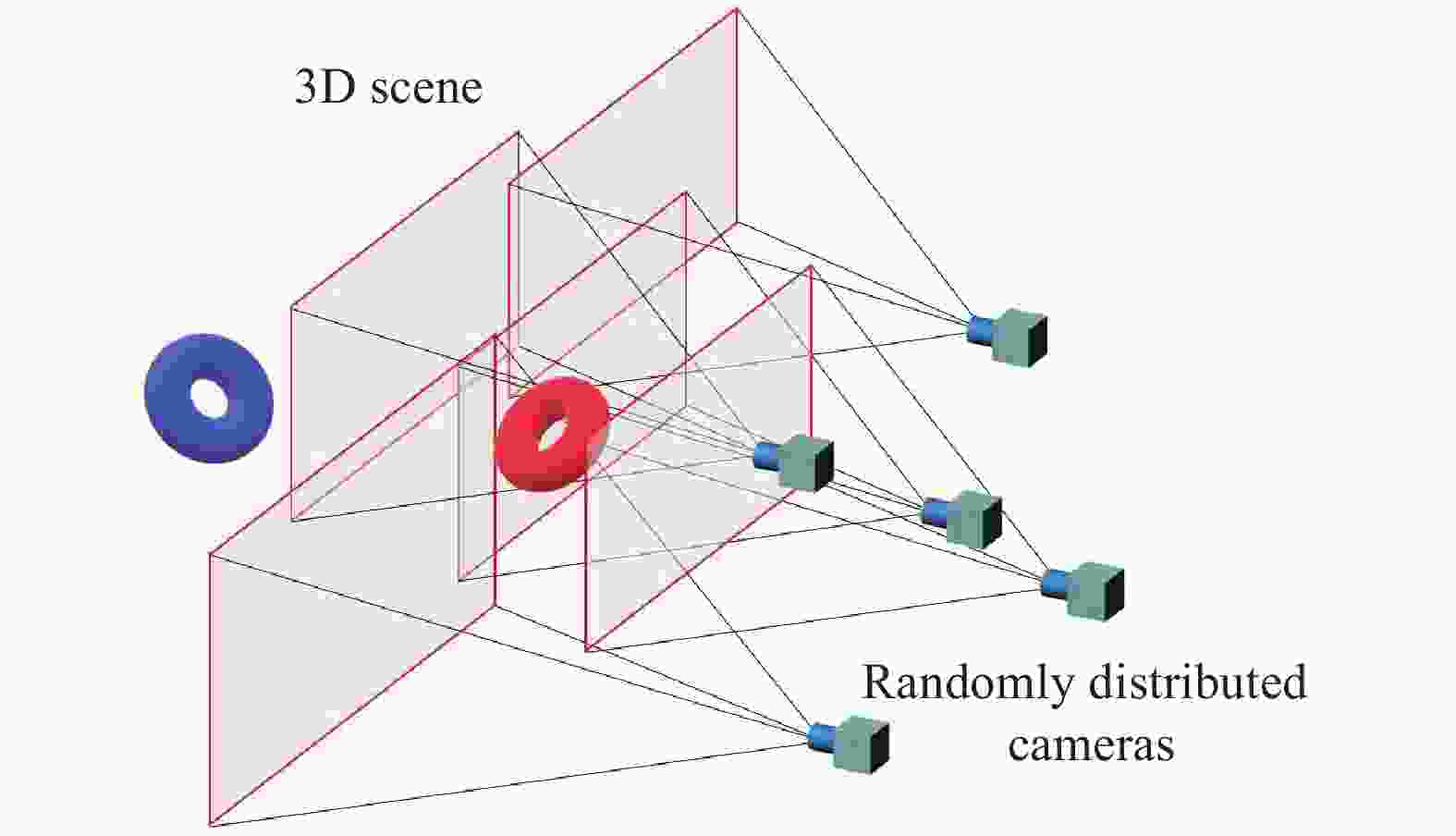

除规则的矩阵式排列外,摄像机在阵列中的位置可以随机分布[33-36],对集成成像3D信息进行获取,如图7所示。这种采集方式对摄像机分布无限制,降低了采集装置的调节工作量,使得装置更为方便灵活。获取的多幅视差图像无需合成微图像阵列,直接在计算机中利用特征点匹配、双视几何、摄像机位姿估计和三维逆向重构还原出三维图像。但是,随机分布的摄像机阵列获取仍然有很多限制条件,如需要将两个或多个摄像机的相对位置作为先验信息对其他摄像机位姿进行估计、所有摄像机光轴需要平行等。此外,特征点匹配和位姿估计等过程将耗费一定时间,算法复杂,计算量大。在摄像机随机分布的采集方式中,也可以通过估计深度信息来渲染虚拟视点图像[37-38],从而完成3D信息获取。

-

尽管摄像机阵列在对集成成像3D信息的获取方面具有优异特性,但是笨重的系统结构和繁琐的摄像机标定等操作使得摄像机阵列并非3D信息获取的理想方案。近年来,随着机器视觉、自动驾驶等领域的飞速发展,各种面向普通消费者的深度相机先后面世。深度相机除获取彩色图像外,更重要的是可以测量到目标场景到相机的距离,即深度信息。采用深度相机能够进行三维扫描和重建,进而实现物体识别和障碍物检测等,同样也能够进行3D信息获取。

目前,主流的深度相机按照原理主要分为三类:结构光、双目视觉、飞行时间法,代表产品有Microsoft Kinect、Leap motion、Intel RealSense、ZED 2 Stereo Camera等。其中,结构光深度相机技术成熟,深度图分辨率较高,但受光照影响,无法在室外应用;双目视觉深度相机成本较低,但深度信息需要依靠特征匹配和三角测量原理计算,算法复杂度较高;基于飞行时间法的深度相机具有较高的抗干扰能力,但深度图分辨率较低,成本高。每种技术都有各自独特的优势和适用场景。

利用深度相机进行集成成像3D信息获取具有结构简单的优势[39-42],能够记录真实场景的3D信息,并通过在计算机中进行图像绘制和像素映射生成多种参数的微图像阵列。同时,深度相机对目标场景的范围无明显限制,能够克服基于微透镜阵列的3D获取装置存在的像差、串扰以及视场小等诸多问题。但是,受深度图分辨率、测量精度、遮挡以及空洞等因素的限制,基于深度相机的集成成像3D信息获取技术还在逐步完善中。

现有的基于深度相机的集成成像3D信息获取主要采用两种方案,一种是在计算机中建立虚拟透镜阵列,以数值计算的方式结合深度信息,将对应彩色纹理图的像素映射到微图像阵列上[40-43],如图8所示。另一种是根据RGBD数据建立3D点云或多边形模型[44-47],基于模型渲染的方式生成图像元或视差图像,最终合成微图像阵列。除利用外置的深度相机和计算机完成3D信息获取外,在智能手机等移动设备上同样也可以实现集成成像3D信息的获取和对应的3D交互显示[48],其中采集的深度图分辨率为640×480,通过转换成点云模型渲染,生成了分辨率为2 126×2 126的微图像阵列。但是,目前还无法利用智能手机自身搭载的3D深度摄像头完成3D信息的获取,仍然需要外接深度相机才能实现。

图 8 基于深度相机的集成成像3D信息获取过程

Figure 8. Integral imaging 3D information acquirement process based on depth camera

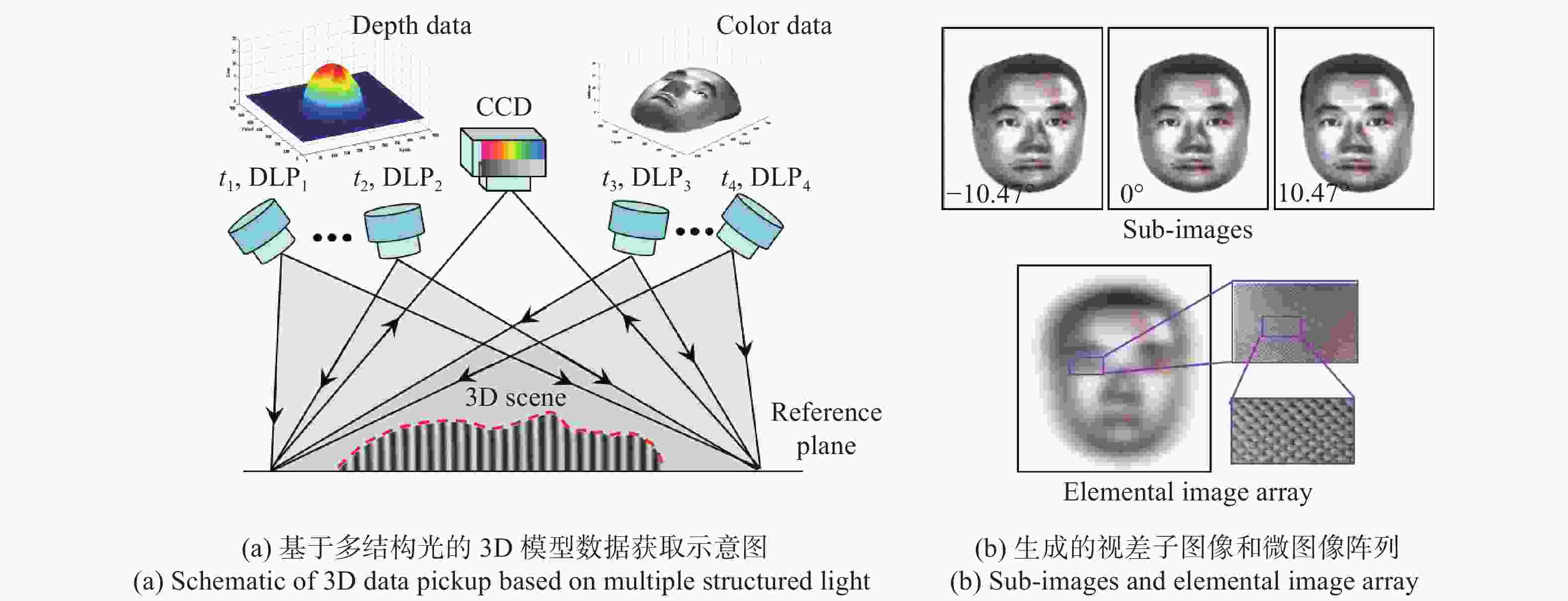

无论深度相机采用何种原理,其本质都是获得目标场景的深度图像。然而,现有的深度相机检测精度都不高,导致3D模型数据和微图像阵列的质量受限。王琼华团队提出一种多结构光的集成成像3D信息获取方案[49],原理如图9所示,该方案利用多个数字投影仪分别以一定时序和角度向目标场景投影数字相位光栅,通过CCD摄像机得到多个被调制的变形的光栅图像和彩色纹理图像,将多个有缺陷的3D模型数据融合为完整且高精度的3D模型数据,解决了单结构光带来的空洞问题,生成了高质量的微图像阵列,分辨率为2 048×1 536个像素。除利用深度相机直接测量场景的深度信息外,还可以通过深度估计的方式获得稠密深度图[38],利用虚拟视点绘制技术生成多个虚拟视点图像,完成集成成像3D信息获取。这里深度估计可以从非结构化单目视频不同帧数据的视差信息得到。

-

集成成像3D显示具有的多种优势使其在3D TV、游戏交互等多个领域具有潜在的应用价值,这就对集成成像3D信息获取和显示的速度提出了更高要求。由于集成成像3D显示多利用光学器件实现3D图像的重建,显示速度主要依赖于LCD或投影仪的刷新频率,现有技术能够完全满足实时显示需求。因此,对于集成成像技术的实时性研究更多集中在集成成像3D信息获取上。集成成像3D信息实时获取主要围绕两条技术路线展开研究,一条是计算机渲染或计算生成,另一条是光学获取加之计算机处理。两条技术路线均与计算机密切相关,可以说,计算机图形学、计算机视觉和GPU并行计算等技术在近些年的兴起带动了集成成像3D信息实时获取技术的发展。

计算机渲染或计算生成路线中,前期代表性的渲染算法有多视点渲染(MVR)[50]、视点矢量渲染(VVR)[51]、并行组渲染(PGR)[52]、图像空间并行计算(ISPP)[53-54]、多光线聚类渲染(MRCR)[55]等,这些算法对单视点图像的渲染效率逐步进行了提升,具体来说,在最初的MVR算法中,每个视点是对单个透镜元进行模拟,当透镜元数目增多时,渲染次数相应增加。VVR和PGR算法将视点图像的渲染次数减少为与单个图像元的像素个数等同,相比MVR算法的渲染速率得到了提升。ISPP和MRCR算法则利用了GPU的并行计算特性,进一步提升了微图像阵列的生成速度,其中,MRCR算法缩短了GPU与CPU数据的传递时间,降低了渲染代价。

在前期渲染算法的基础上,王琼华团队提出了一种多视框体融合渲染算法(MOFC),仅对3D场景进行单次渲染即可生成微图像阵列[56],针对4 k分辨率的微图像阵列,3D信息获取速率可达45 帧/s。如图10所示,该算法事先对3D场景进行复制,并在世界坐标系下完成平移和旋转变换,将原有的多个正交投影视框体融合得到渲染结果相同的单个正交投影视框体,再进行单次渲染即可完成正交投影图像阵列的生成。这里的单次渲染指只从CPU向GPU传递一次3D场景相关数据,在启动渲染后,这些数据将得到重复利用,从而减少了CPU到GPU数据传输耗费的计算时间。同时,利用GPU并行计算实现像素映射,可将正交投影图像阵列转换为微图像阵列,进一步提高了计算效率。代表性的渲染算法还有透镜渲染算法(LBR)[57],能够同时兼顾渲染帧率和图像质量,并且无需进行像素重采样和视点插值。

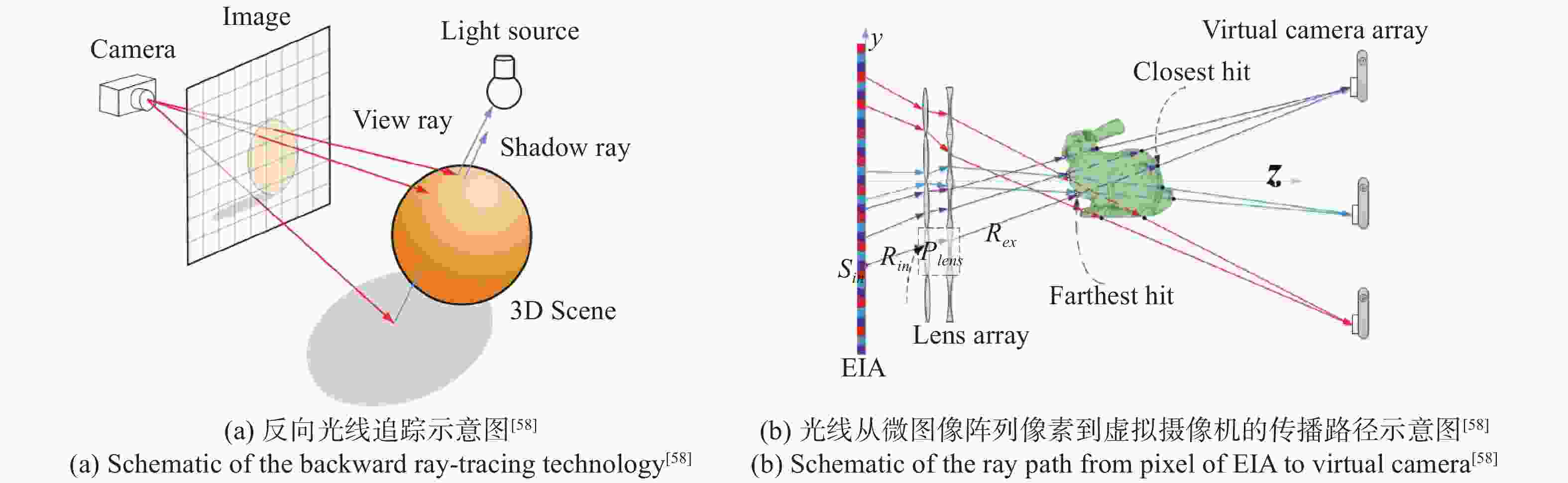

上述计算机集成成像3D获取都基于栅格化的图形渲染算法。除栅格化图形渲染外,还可以利用反向光线追踪实现集成成像3D信息的实时获取[58],如图11所示。反向光线追踪无需渲染多个视点图像,而是直接定义从虚拟摄像机到微图像阵列上像素的光线,通过检测光线与虚拟场景中物体的碰撞,根据碰撞点的材质情况进行光线反射与折射,直到遇到光源[59]。与栅格化图形渲染算法相比,反向光线追踪更能模拟真实世界光线的物理特性,图形更加逼真[59]。同时,配合GPU能够实现实时的微图像阵列生成,帧率超过40 帧/s[60]。

光学获取加之计算机处理路线中,可在透镜阵列[61]或摄像机阵列[31]拍摄后,利用计算机实时处理视差图像,生成微图像阵列。基于透镜阵列的3D信息实时获取需要解决获取和显示参数不匹配以及深度反转等问题,基于摄像机阵列的3D信息获取则需要完成实时的解码、颜色空间变换、几何空间校正以及3D视频合成。第4部分中,王琼华团队搭建的集成成像3D实时获取系统利用8×8网络摄像机阵列进行拍摄,并在计算机中实时处理,实现了平均37 帧/s的3D信息获取速率。此外,王琼华团队还利用双目相机进行了3D场景拍摄[62],在GPU中完成了高分辨率深度图、视差图像和微图像阵列的生成,实现了集成成像3D信息的实时获取和显示。

-

文中系统综述了集成成像3D信息获取技术的进展,包括微透镜阵列、摄像机阵列和深度相机,还介绍了集成成像3D信息实时获取的发展历程和研究现状,但这些依然无法涵盖集成成像3D信息获取技术的全部研究工作。从集成成像的角度来看,集成成像3D信息获取的主要目的是为对应的显示过程提供3D内容,这就使得无论何种采用获取方式,都需要将得到的原始数据进行处理,才能够与显示过程匹配。不同的获取方式各自具有不同的优势,也面临着不同的挑战。表1横向比较了文中所述的三种集成成像3D信息获取方式在结构、获取速度、数据量、获取分辨率、采集视场、微图像阵列质量、成本及体积等方面的参数。可以看出,基于微透镜阵列的集成成像3D信息获取方式结构最简单,获取速度最快,数据量最小,然而获取分辨率却最低、采集视场也最小;基于摄像机阵列的集成成像3D信息获取方式采集视场最大,获取分辨率最高,但是结构也最为复杂,数据量大,获取速度慢,成本也最高;基于深度相机的集成成像3D信息获取方式平衡了上述两种获取方式的多项参数,整体3D信息获取性能处于中等。

表 1 三种集成成像3D信息获取方式的参数比较

Table 1. Parameter comparison between three integral imaging 3D information acquisition technologies

Complexity of system Pickup speed Amount of data Pickup resolution FOV EIA quality Cost Size Microlens array Low High Small Low Small Low Low Small Camera array High Low Large High Large High High Large Depth camera Moderately low Moderately low Moderately small Moderately high Moderately large Moderately low Moderately low Small 除了为集成成像3D显示提供内容外,集成成像3D信息获取还可以作为一种多维度信息获取手段,在被遮挡场景的探测成像和目标识别追踪、2D/3D信息加密、显微3D成像等领域实现应用。就2D/3D信息加密来说,集成成像3D信息获取得到的微图像阵列同时包含了目标场景不同空间位置和不同方向的信息,具有冗余特性,因此将获取过程作为加密算法的一部分,具有较高的安全性,能够抵抗多种类型的攻击。可以看出,集成成像获取3D信息的应用空间还有很大,在未来的研究中,与不同领域实际应用的结合也是相关科研人员的一个努力方向。

总之,集成成像3D信息获取技术能够记录目标场景不同角度的视差信息,不仅为集成成像3D显示提供匹配片源,还可以作为新型的多维度信息获取手段,为计算机视觉等方向提供新的思路,在科学研究、工业检查、农业生产、医疗影像、环境检查及军事侦察等领域具有较大的应用价值。随着新型成像器件的不断研发和人工智能技术的迭代更新,集成成像3D信息获取技术的潜力将不断被开发,相应的应用方向也将不断拓展。

3D information acquisition technology of integral imaging

-

摘要: 集成成像作为一种新型裸眼三维(3D)显示技术,能够完整获取3D信息并还原再现,是目前最具发展前景的裸眼3D显示技术之一。其中,对3D信息的完整获取通过记录场景不同角度的视差信息,并以微图像阵列形式进行呈现,不仅能够为集成成像显示提供3D内容,更作为一种多维度信息获取手段,在被遮挡场景的探测成像、目标识别、2D/3D信息加密和显微3D成像等多个领域得到应用。文中对集成成像3D信息获取的基本原理、不同类型的集成成像3D信息获取技术以及集成成像3D信息实时获取技术进行综述,并讨论现存的一些问题以及未来发展趋势。Abstract: As a novel auto-stereoscopic three-dimensional (3D) display technology, integral imaging is able to acquire complete 3D information of the 3D scene and reconstruct it. Thus, integral imaging is one of the most promising technologies of the glasses-free 3D displays. In the integral imaging 3D information acquisition process, different perspectives of the 3D scene are recorded to generate the elemental image array to be the 3D content for the integral imaging display. On the other hand, the integral imaging 3D acquisition can be a multi-dimensional information pickup approach applied to the detection and imaging of occluded scenes, target recognition, two-dimensional (2D) / 3D information encryption and microscopic 3D imaging fields. The basic principles, different types of the integral imaging 3D information acquisition approaches, and real-time 3D information acquisition technologies were reviewed in this paper. Some challenging problems and future development trend of the technology were also discussed.

-

表 1 三种集成成像3D信息获取方式的参数比较

Table 1. Parameter comparison between three integral imaging 3D information acquisition technologies

Complexity of system Pickup speed Amount of data Pickup resolution FOV EIA quality Cost Size Microlens array Low High Small Low Small Low Low Small Camera array High Low Large High Large High High Large Depth camera Moderately low Moderately low Moderately small Moderately high Moderately large Moderately low Moderately low Small -

[1] Lippmann G. La photographie integrale [J]. Comptes Rendus Academie Sci, 1908, 146: 446−451. [2] Martínez-Corral M, Javidi B. Fundamentals of 3D imaging and displays: a tutorial on integral imaging, light-field, and plenoptic systems [J]. Advances in Optics and Photonics, 2018, 10(3): 512−566. doi: 10.1364/AOP.10.000512 [3] Martínez-Corral M, Dorado A, Barreiro J C, et al. Recent advances in the capture and display of macroscopic and microscopic 3-D scenes by integral imaging [J]. Proceedings of the IEEE, 2017, 105(5): 825−836. doi: 10.1109/JPROC.2017.2655260 [4] Yang J C, Everett M, Buehler C, et al. A real-time distributed light field camera [J]. Rendering Techniques, 2002, 2002: 77−86. [5] Ng R, Levoy M, Brédif M, et al. Light field photography with a hand-held plenoptic camera [J]. Computer Science Technical Report CSTR, 2005, 2(11): 1−11. [6] Xiao X, Javidi B, Martinez-Corral M, et al. Advances in three-dimensional integral imaging: sensing, display, and applications [J]. Applied Optics, 2013, 52(4): 546−560. doi: 10.1364/AO.52.000546 [7] Martinez-Cuenca R, Pons A, Saavedra G, et al. Optically-corrected elemental images for undistorted integral image display [J]. Optics Express, 2006, 14(21): 9657−9663. doi: 10.1364/OE.14.009657 [8] Arai J, Okano F, Hoshino H, et al. Gradient-index lens-array method based on real-time integral photography for three-dimensional images [J]. Applied Optics, 1998, 37(11): 2034−2045. doi: 10.1364/AO.37.002034 [9] Hahn J, Kim Y, Kim E H, et al. Undistorted pickup method of both virtual and real objects for integral imaging [J]. Optics Express, 2008, 16(18): 13969−13978. doi: 10.1364/OE.16.013969 [10] Ives H E. Optical properties of a Lippmann lenticulated sheet [J]. Journal of the Optical Society of America, 1931, 21(3): 171−176. doi: 10.1364/JOSA.21.000171 [11] Jang J S, Javidi B. Two-step integral imaging for orthoscopic three-dimensional imaging with improved viewing resolution [J]. Optical Engineering, 2002, 41(10): 2568−2572. doi: 10.1117/1.1505961 [12] Okano F, Hoshino H, Arai J, et al. Real-time pickup method for a three-dimensional image based on integral photography [J]. Applied Optics, 1997, 36(7): 1598−1603. doi: 10.1364/AO.36.001598 [13] Navarro H, Martínez-Cuenca R, Saavedra G, et al. 3D integral imaging display by smart pseudoscopic-to-orthoscopic conversion (SPOC) [J]. Optics Express, 2010, 18(25): 25573−25583. doi: 10.1364/OE.18.025573 [14] Xiao X, Shen X, Martinez-Corral M, et al. Multiple-planes pseudoscopic-to-orthoscopic conversion for 3D integral imaging display [J]. Journal of Display Technology, 2015, 11(11): 921−926. doi: 10.1109/JDT.2014.2387854 [15] Martínez-Corral M, Dorado A, Navarro H, et al. Three-dimensional display by smart pseudoscopic-to-orthoscopic conversion with tunable focus [J]. Applied Optics, 2014, 53(22): E19−E25. doi: 10.1364/AO.53.000E19 [16] Wang Z, Lv G, Feng Q, et al. A fast-direct pixel mapping algorithm for displaying orthoscopic 3D images with full control of display parameters [J]. Optics Communications, 2018, 427: 528−534. doi: 10.1016/j.optcom.2018.06.067 [17] Yan Z, Jiang X, Yan X. Performance-improved smart pseudoscopic to orthoscopic conversion for integral imaging by use of lens array shifting technique [J]. Optics Communications, 2018, 420: 157−162. doi: 10.1016/j.optcom.2018.03.061 [18] Deng H, Wang Q H, Li D H, et al. Realization of undistorted and orthoscopic integral imaging without black zone in real and virtual fields [J]. Journal of Display Technology, 2011, 7(5): 255−258. doi: 10.1109/JDT.2011.2106761 [19] Jang J S, Javidi B. Formation of orthoscopic three-dimensional real images in direct pickup one-step integral imaging [J]. Optical Engineering, 2003, 42(7): 1869−1871. doi: 10.1117/1.1584054 [20] Zhang J L, Wang X R, Chen Y J, et al. Feasibility study for pseudoscopic problem in integral imaging using negative refractive index materials [J]. Optics Express, 2014, 22(17): 20757−20769. doi: 10.1364/OE.22.020757 [21] Algorri J F, Urruchi V, Bennis N, et al. Integral imaging capture system with tunable field of view based on liquid crystal microlenses [J]. IEEE Photonics Technology Letters, 2016, 28(17): 1854−1857. doi: 10.1109/LPT.2016.2572258 [22] Martínez-Corral M, Javidi B, Martínez-Cuenca R, et al. Integral imaging with improved depth of field by use of amplitude-modulated microlens arrays [J]. Applied Optics, 2004, 43(31): 5806−5813. doi: 10.1364/AO.43.005806 [23] Luo C G, Wang Q H, Deng H, et al. Extended depth-of-field in integral-imaging pickup process based on amplitude-modulated sensor arrays [J]. Optical Engineering, 2015, 54(7): 073108. doi: 10.1117/1.OE.54.7.073108 [24] Luo C G, Deng H, Li L, et al. Integral imaging pickup method with extended depth-of-field by gradient-amplitude modulation [J]. Journal of Display Technology, 2016, 12(10): 1205−1211. doi: 10.1109/JDT.2016.2580098 [25] Yim J, Choi K H, Min S W. Real object pickup method of integral imaging using offset lens array [J]. Applied Optics, 2017, 56(13): F167−F172. doi: 10.1364/AO.56.00F167 [26] Jeong Y, Kim J, Yeom J, et al. Real-time depth controllable integral imaging pickup and reconstruction method with a light field camera [J]. Applied Optics, 2015, 54(35): 10333−10341. doi: 10.1364/AO.54.010333 [27] Jang J S, Javidi B. Three-dimensional synthetic aperture integral imaging [J]. Optics Letters, 2002, 27(13): 1144−1146. doi: 10.1364/OL.27.001144 [28] Wilburn B, Joshi N, Vaish V, et al. High performance imaging using large camera arrays[C]//ACM Transactions on Graphics (TOG), 2005, 24(3): 765-776. [29] Taguchi Y, Koike T, Takahashi K, et al. TransCAIP: A live 3D TV system using a camera array and an integral photography display with interactive control of viewing parameters [J]. IEEE Transactions on Visualization and Computer Graphics, 2009, 15(5): 841−852. doi: 10.1109/TVCG.2009.30 [30] Deng H, Wang Q, Li D. Method of generating orthoscopic elemental image array from sparse camera array [J]. Chinese Optics Letters, 2012, 10(6): 061102. doi: 10.3788/COL201210.061102 [31] Xing Y, Xiong Z L, Zhao M, et al. Real-time integral imaging pickup system using camera array[C]//Advances in Display Technologies VIII. International Society for Optics and Photonics, 2018, 10556: 105560D. [32] Xiong Z L, Xing Y, Deng H, et al. 19‐1: Planar parallax based camera array calibration method for integral imaging three‐dimensional information acquirement[C]//SID Symposium Digest of Technical Papers. 2016, 47(1): 219−222. [33] Danesh Panah M, Javidi B, Watson E A. Three dimensional imaging with randomly distributed sensors [J]. Optics Express, 2008, 16(9): 6368−6377. doi: 10.1364/OE.16.006368 [34] Xiao X, DaneshPanah M, Cho M, et al. 3D integral imaging using sparse sensors with unknown positions [J]. Journal of Display Technology, 2010, 6(12): 614−619. doi: 10.1109/JDT.2010.2070485 [35] Zhang M, Zhong Z, Piao Y, et al. Three-dimensional integral imaging with circular non-uniform distribution [J]. Optics and Lasers in Engineering, 2020, 126: 105912. doi: 10.1016/j.optlaseng.2019.105912 [36] Yi F, Lee J, Moon I. Three-dimensional integral imaging by using unknown sensor array position calibration with a closed-form solution [J]. Optical Engineering, 2016, 55(2): 023104. doi: 10.1117/1.OE.55.2.023104 [37] Sotoca J M, Latorre-Carmona P, Pla F, et al. Integral imaging techniques for flexible sensing through image-based reprojection [J]. Journal of the Optical Society of America A, 2017, 34(10): 1776−1786. doi: 10.1364/JOSAA.34.001776 [38] Wei J, Wang S, Zhao Y, et al. Synthetic aperture integral imaging using edge depth maps of unstructured monocular video [J]. Optics Express, 2018, 26(26): 34894−34908. doi: 10.1364/OE.26.034894 [39] Shin D H, Lee S H, Kim E S. Optical display of true 3D objects in depth-priority integral imaging using an active sensor [J]. Optics Communications, 2007, 275(2): 330−334. doi: 10.1016/j.optcom.2007.03.072 [40] Li G, Kwon K C, Shin G H, et al. Simplified integral imaging pickup method for real objects using a depth camera [J]. Journal of the Optical Society of Korea, 2012, 16(4): 381−385. doi: 10.3807/JOSK.2012.16.4.381 [41] Jeong J S, Kwon K C, Erdenebat M U, et al. Development of a real-time integral imaging display system based on graphics processing unit parallel processing using a depth camera [J]. Optical Engineering, 2014, 53(1): 015103. doi: 10.1117/1.OE.53.1.015103 [42] Yoo H. Transformations and their analysis from a RGBD image to elemental image array for 3D integral imaging and coding [J]. KSII Transactions on Internet and Information Systems, 2018, 12(5): 2273−2286. [43] Hong S, Dorado A, Saavedra G, et al. Three-dimensional integral-imaging display from calibrated and depth-hole filtered kinect information [J]. Journal of Display Technology, 2016, 12(11): 1301−1308. doi: 10.1109/JDT.2016.2594076 [44] Erdenebat M U, Piao Y L, Darkhanbaatar N, et al. Advanced mobile three-dimensional display based on computer-generated integral imaging[C]//Optics, Photonics, and Digital Technologies for Imaging Applications V. International Society for Optics and Photonics, 2018, 10679: 106790I. [45] Jeong J S, Erdenebat M U, Kwon K C, et al. Real object-based integral imaging system using a depth camera and a polygon model [J]. Optical Engineering, 2017, 56(1): 013110. doi: 10.1117/1.OE.56.1.013110 [46] Hong S, Saavedra G, Martinez-Corral M. Full parallax three-dimensional display from Kinect v1 and v2 [J]. Optical Engineering, 2016, 56(4): 041305. doi: 10.1117/1.OE.56.4.041305 [47] Ikeya K, Arai J, Mishina T, et al. Capturing method for integral three-dimensional imaging using multiviewpoint robotic cameras [J]. Journal of Electronic Imaging, 2018, 27(2): 023022. [48] Erdenebat M U, Kim B J, Piao Y L, et al. Three-dimensional image acquisition and reconstruction system on a mobile device based on computer-generated integral imaging [J]. Applied Optics, 2017, 56(28): 7796−7802. doi: 10.1364/AO.56.007796 [49] Xiong Z L, Wang Q H, Xing Y, et al. Active integral imaging system based on multiple structured light method [J]. Optics Express, 2015, 23(21): 27094−27104. doi: 10.1364/OE.23.027094 [50] Halle M. Multiple viewpoint rendering[C]//SIGGRAPH, 1998, 98: 243−254. [51] Min S W, Park K S, Lee B, et al. Enhanced image mapping algorithm for computer-generated integral imaging system [J]. Japanese Journal of Applied Physics, 2006, 45(7L): L744. [52] Min S W, Kim J, Lee B. New characteristic equation of three-dimensional integral imaging system and its applications [J]. Japanese Journal of Applied Physics, 2004, 44(1L): L71. [53] Kwon K C, Park C, Erdenebat M U, et al. High speed image space parallel processing for computer-generated integral imaging system [J]. Optics Express, 2012, 20(2): 732−740. doi: 10.1364/OE.20.000732 [54] Kim D H, Erdenebat M U, Kwon K C, et al. Real-time 3D display system based on computer-generated integral imaging technique using enhanced ISPP for hexagonal lens array [J]. Applied Optics, 2013, 52(34): 8411−8418. doi: 10.1364/AO.52.008411 [55] Jiao S, Wang X, Zhou M, et al. Multiple ray cluster rendering for interactive integral imaging system [J]. Optics Express, 2013, 21(8): 10070−10086. doi: 10.1364/OE.21.010070 [56] Li S L, Wang Q H, Xiong Z L, et al. Multiple orthographic frustum combing for real-time computer-generated integral imaging system [J]. Journal of Display Technology, 2014, 10(8): 704−709. doi: 10.1109/JDT.2014.2315665 [57] Chen G, Ma C, Fan Z, et al. Real-time lens based rendering algorithm for super-multiview integral photography without image resampling [J]. IEEE Transactions on Visualization and Computer Graphics, 2017, 24(9): 2600−2609. [58] Xing S, Sang X, Yu X, et al. High-efficient computer-generated integral imaging based on the backward ray-tracing technique and optical reconstruction [J]. Optics Express, 2017, 25(1): 330−338. doi: 10.1364/OE.25.000330 [59] Wikipedia. Ray tracing (graphics)[EB/OL]. [2020-01-10]. https://en.wikipedia.org/wiki/Ray_tracing_(graphics). [60] Huo W, Sang X, Xing S, et al. Backward ray tracing based rectification for real-time integral imaging display system [J]. Optics Communications, 2020, 458: 124752. doi: 10.1016/j.optcom.2019.124752 [61] Choi J G, Choi H M, Hwang Y S, et al. Real-time sensing and three-dimensional display of far outdoor scenes based on asymmetric integral imaging [J]. Optics and Lasers in Engineering, 2017, 94: 44−57. doi: 10.1016/j.optlaseng.2017.02.013 [62] Zhao Min, Xiong Zhaolong, Xing Yan, et al. Real-time integral imaging pickup system based on binocular stereo camera [J]. Infrared and Laser Engineering, 2017, 46(11): 1103007. (in Chinese) doi: 10.3788/IRLA201746.1103007 -

点击查看大图

点击查看大图

计量

- 文章访问数: 1929

- HTML全文浏览量: 716

- 被引次数: 0

下载:

下载: