-

目标跟踪广泛应用于智能监控、智能交通、人机交互、机器人导航等民用领域[1-3],以及远程无人机打击、前视红外、精确制导等军事领域[4-6],是计算机视觉领域的重要研究方向之一。近年来,深度学习开始应用于目标跟踪并逐步占据主导地位,但在面临不可预知的复杂环境时,如目标遮挡、几何形变、背景扰动、移出视野和快速运动等,还不能达到很好的效果。

卷积神经网络因学习获得的深度特征具有强大的目标表达能力,逐渐取代传统的手工特征,并被引入到目标跟踪任务中取得了很大的发展[7-9]。目前主流的跟踪算法包括相关滤波类和基于深度学习的跟踪方法。相关滤波类[10-14]利用循环矩阵的性质,在傅里叶域推导了相关滤波的闭解,在保证跟踪精度的同时达到了非常快的速度。早期基于深度学习的跟踪方法[15-18]由于需要对深度网络在线进行微调,很难达到实时,例如MDNet[19]算法在跟踪的过程中,针对跟踪目标重建后面的全连接层,通过在线微调来区分目标和背景,跟踪速度只能达到1FPS。在最近两年,基于孪生网络的深度学习跟踪方法通过在大规模数据集上进行端到端的离线训练,直接输出目标分类得分和目标框回归结果,该方法在精度和在线跟踪速度方面的巨大潜力使其成为近两年目标跟踪领域的一个研究热点。

基于孪生网络的跟踪方法中,SINT[20]将跟踪问题看作是一个分类验证问题,通过孪生网络对相似性度量函数进行学习,然后在上一帧的特征空间寻找最相近的区域块。虽然SINT采用光流法和自适应采样策略来减少候选目标的数量,但还是因为候选目标数量庞大,导致工作速度远远不能满足实时性要求。基于孪生网络结构的GOTURN[21]通过全连接层能直接获取目标位置和尺度,在GPU上的运行速度可以达到100 FPS。由于该模型不能实现模型的在线更新,算法的鲁棒性与当时的主流算法相比相对要差。SiamFC[22]在孪生网络的两个分支直接进行卷积运算,通过响应的最大值确定目标的位置。SiamFC只能估计目标的中心位置,而要想对目标的尺寸进行估计,只有通过多尺度测试来预测尺度的变化,这种方式不仅增加了计算量,同时也不够精确。自SiamFC提出以来,出现了一系列基于SiamFC的改进算法。DSiam[23]没有直接采用前一帧的目标特征作为模板,而是将第一帧的目标特征进行系列变化后使用。RFL[24]利用卷积长短时记忆网络来动态的生成模板,但没有显著提升总体跟踪性能。FlowTrack[25]引入光流来对历史帧进行配准,利用时空注意力机制融合对齐后的特征,有效的提高了网络在线应对目标形变的适应能力。SA-Siam[26]采用语义特征和表观特征互补的形式,先分别得到各自的响应,最后再加权求和来估计目标位置。SiamRPN[27]通过引入区域建议网络来对目标进行分类和回归,通过锚点结构直接给出目标位置和尺度信息,端到端的网络设计不需要多尺度预测,进一步提高了目标跟踪的速度和鲁棒性。DaSiamRPN[28]利用目标检测结果来扩展训练数据集,构建语义信息丰富的负样本进行离线训练,来提高网络的辨别能力,并利用了历史帧的上下文信息来解决相似干扰因素的影响。

SiamRPN类跟踪方法在离线阶段通过在大规模数据集上进行训练,具有很强的泛化能力,在处理目标形变方面具有明显的优势。但局限性在于虽然对目标的各种形变不敏感,但对相似性目标的分辨能力较差,如图1所示。SiamRPN采用的措施是通过加余弦窗和尺度惩罚的方式,选择离上一帧目标较近的相关响应峰值作为跟踪结果,这显然与目标跟踪能区分单个目标的任务不相适用。如何保证模型具有很强泛化能力的同时,提高区分跟踪目标与其他干扰物的能力是需要解决的主要难点问题。

-

文中在SiamRPN的基础上,设计了一种基于孪生网络的两阶段跟踪方法,主要解决一阶段的孪生网络为适应目标各种形变无法兼顾对相似性目标的区分,网络结构如图2所示。网络的输入为参考图像

${\textit{z}}$ 和以上一帧目标为中心的小范围搜索区域$x$ ,两者经共享权值的主干网络提取对应的深度特征${f_{\theta} }({\textit{z}})$ 和${f_{\theta} }(x)$ ,主干网络采用了更深的残差网络Resnet50;${f_{\theta} }({\textit{z}})$ 经相关滤波(Correlation Filter,CF)调制得到目标模板${{w}}$ ,模板通过滑动平均的方式进行自适应更新,以综合时域信息提高目标的显著性。接着将模板${{w}}$ 作为卷积核与${f_{\theta} }(x)$ 进行卷积运算,计算得到的相关矩阵输入到区域建议网络(Region Proposal Network,RPN)完成背景和目标的初步分类;最后,使用感兴趣池化层(RoI Pooling)将候选区域转化为固定尺度的特征,与模板特征一起进行更精细化的分类与回归。 -

SiamRPN算法的主干网络采用的是AlexNet网络,使用conv5层的特征对目标进行不同尺度和长宽比的预测,不能提供多元化的特征表示。一般来说,深度网络不同层具有不同的意义,这里采用更深的ResNet50网络进行实验,分析提取不同层次的特征对于模型性能的影响。考虑到感受野的变化,深层特征具有丰富的语义信息,在运动模糊、大形变等挑战场景中更有利于定位。

为了将更深的网路ResNet50运用于孪生网络跟踪,需要对模型的结构进行一下调整:在原来的ResNet50中,步长为32,特征尺度太小不适合相关运算,通过修改P3和P4模块,取消了下采样操作,代替以空洞卷积层来扩大其感受野;因为多次叠加空洞卷积会损失信息的连续性,因此空洞卷积只使用在残差单元中第二个卷积层。

为了分析网络的深度对SiamRPN跟踪性能的影响,提取了ResNet50不同深度的特征层输入到区域建议网络进行训练。利用OTB数据集对训练好的多个模型进行了测试,结果表明采用AlexNet网络模型的跟踪精度为0.805,采用ResNet50网络的P2、P3和P4模块输出进行预测的跟踪精度分别为0.823、0.830、0.813,可以看到采用P3特征层的模型精度最高,说明并不是深度越深精度越高。因此特征提取模块采用了调整后的Resnet50网络,提取P3特征层进行区域建议,使模型实现更优的性能。图3分别为采用不同基础网络提取的特征可视化,可以看到修改后ResNe50网络提取的特征质量更高,具有更好的应对背景干扰的能力。

-

为了提高区域建议网络提取候选目标的质量,改进方法是通过相关滤波调制在RPN阶段对模板进行自适应更新,具体过程如图2中的CF模块。对于获取的目标特征先与相关滤波算子相乘,计算获得的目标模板再与搜索区域特征做互相关运算得到高斯形状的相关响应,经相关滤波之后的互相关响应可以表示为:

相关滤波模板

${{w}} \in {{\mathbb{R}}^{m \times m}}$ 的求解通过最小化目标函数得到,并通过时域到频域的转化提高矩阵的运算速度。对于给定的训练样本${{Z}} \in {{\mathbb{R}}^{d \times n}}$ , 该优化问题可以描述为:式中:

${{y}} \in {{\mathbb{R}}^n}$ 和$\lambda $ 分别表示目标函数和正则化系数。将${{{Z}}^{\rm{T}}}{{w}} - {{y}}$ 用${{r}}$ 表示,采用拉格朗日乘数法求解优化问题[29]:式中:

${{v}}$ 为拉格朗日乘子,将该式进行求导运算,并令偏导数为0,得到目标模板${{w}}$ 的表达式为:式中:

$ ^{\wedge} $ 表示傅里叶变换;$ \odot $ 表示矩阵的点乘。通过变换到傅里叶域后,相关滤波的计算变为元素点乘的形式,可以加快运算速度。相关滤波调制的优点是在跟踪的过程中,模型可以综合历史帧进行自适应更新,提高跟踪目标的显著性,模板更新采用滑动平均的更新策略:式中:

$\eta $ 为目标模板学习系数,实验中取0.9。为了进行对比分析,这里对原始网络和使用相关滤波调制后的网络在GOT-10k同一个数据集上进行训练,通过提取网络中间层的分类响应进行比较。如图4所示,第一行为原始网络的区域建议结果,第二行为改进之后的网络输出结果。从响应图对比可以看到,通过相关滤波调制之后,目标候选框取样更多的集中到了目标附近。改进之后的网络可以提高目标的显著性,在RPN阶段过滤掉易区分的负样本,像第一组序列中右下角的摩托车、第2组序列中三轮车附近的干扰车辆。更加准确的候选框提取有助于减轻第二阶段验证网络的分类压力,降低虚警率。

-

泛化能力强会带来高的误检率,这就是一阶段孪生网络SiamRPN无法很好的将目标与相似干扰物区分开来的原因。前面针对区域建议网络增加了相关滤波调制来提高目标的显著性,但还不能完全解决高难度样本的区分,因此设计了区域建议加精细验证的两阶段网络结构。

如图5所示,区域建议网络获得的多个候选区域利用感兴趣池化层(Region of Interest pooling, RoI poooling)提取候选框各自的特征,馈送到验证网络进行进步的分类和回归。对于分类分支,提取的候选区域特征先通过2个DBL卷积组对特征进行优化,再经池化层和后续的全连接层得到分类向量,最后与模板的特征向量进行相似性度量。对于回归分支,候选目标特征先与模板特征进行相关运算,再进行目标框的回归。目标跟踪的核心任务要求模型能够区分单个个体,因此设计的验证网络需要在训练过程中使得模型输出的特征具有较强的分辨力,即满足目标与跟踪过程中各个状态之间的距离要小于与干扰物之间的距离。

对于目标特征

${{z}} \in {{\mathbb{R}}^{k \times k \times c}}$ 和第$i$ 个候选框${{{c}}_i} \in {{\mathbb{R}}^{k \times k \times c}}$ ,为了增加分类的辨别力,将正负样本组成样本对$T=\left\{ {\left\langle {{{{c}}_i},{{{c}}_j},{{z}}} \right\rangle } \right\}$ 来训练损失函数,其中$\left\langle {{{{c}}_i},{{z}}} \right\rangle$ 来自同一目标的样本特征,$\left\langle {{{{c}}_j},{{z}}} \right\rangle$ 来自不同目标的样本特征,对于N个集合,分类损失可以表示为:式中:

$d$ 为目标与样本的距离;$m>0$ 为预设边际值。对于回归分支,采用跟踪模板引导目标框回归的形式,首先对候选框特征进行调制来编码相关运算:式中:

$ \odot $ 表示哈德曼乘积;${h_x}$ 和${h_z}$ 为特征映射,采用3×3的卷积;${h_{out}}$ 是为了保证得到需要的特征维度,采用1×1的卷积。网络训练采用Smoth L1损失:式中:

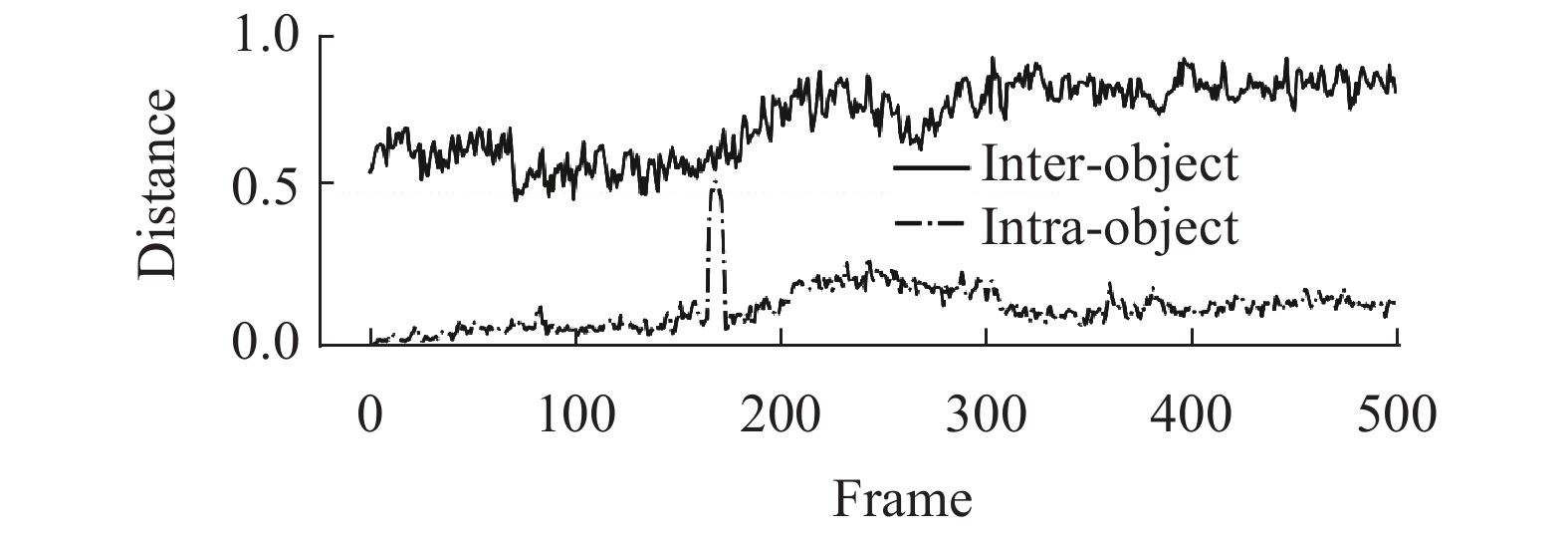

${p_i}$ 为估计的中心位置和尺度偏差;${q_i}$ 为标签;$s_i^ * $ 表示第$i$ 个候选框是否判断为目标。通过正负样本对联合训练的方式可以大大提高模型的分类本领,图6为训练10代之后的模型在跟踪UAV123-group1 过程中对不同样本的分类结果,目标周围同时存在其他人不定时的交叉影响。虚线为第一帧目标与后面各状态之间的相似性度量,实线为目标与周围干扰项之间的相似性度量,度量函数采用余弦距离。可以看到在整个跟踪过程中,验证网络对同类物体具有很好的分辨力,弥补了SiamRPN分辨能力差的缺点。

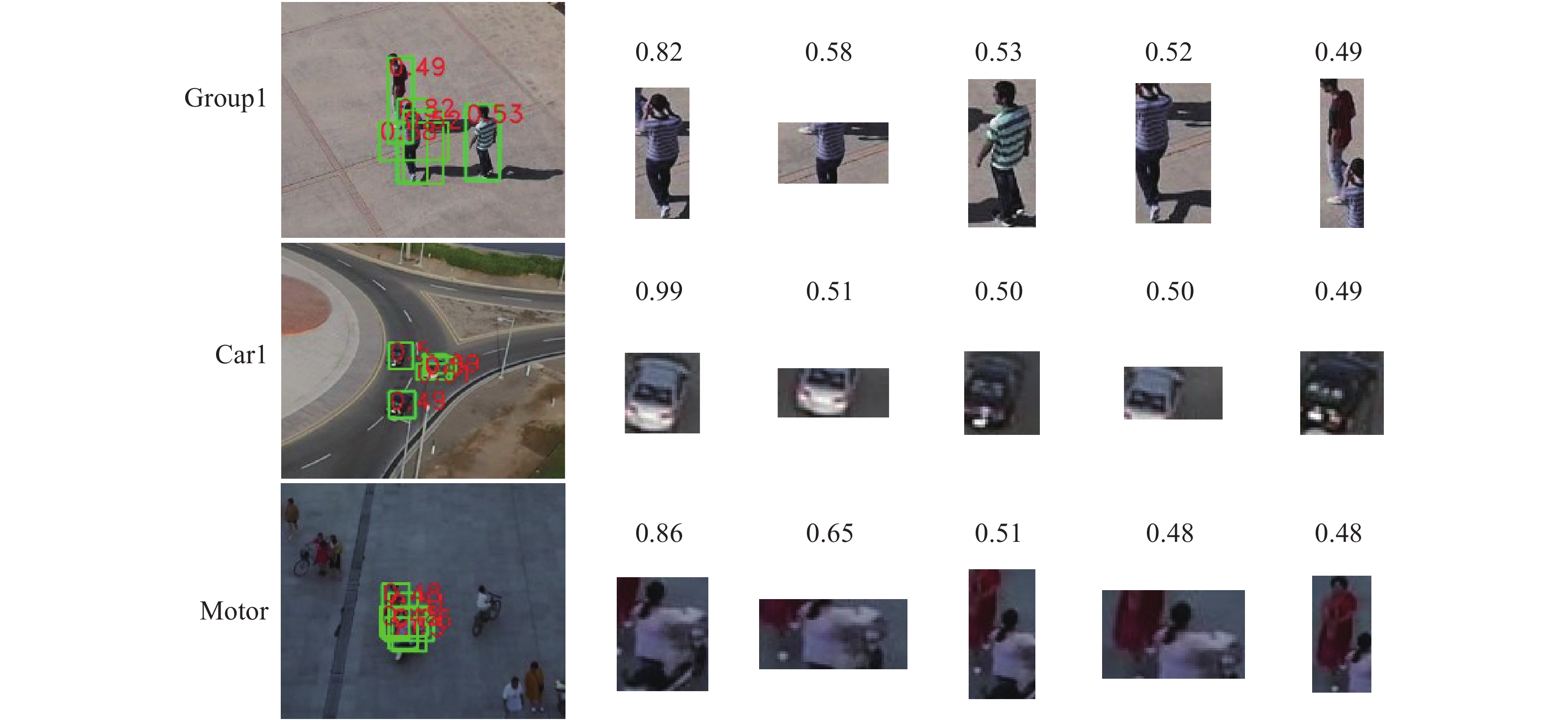

图7选取了多个样本组进行进步的分析,从它们的对比结果可以看出,同一个体的多个取样间余弦距离都较小,不同个体的取样之间距离相对较大。在目标发生部分遮挡与剧烈形变的情况下,分类距离有所上升,但依然可以将之与干扰物区分开来。

-

综合上述对文中算法关键部分的描述,主要跟踪步骤如下所示。

输入:视频序列I1, I2,···, In,初始目标位置

${p_0}=({x_0},{y_0})$ ,初始目标尺寸${s_0}=({w_0},{h_0})$ 输出:每一帧目标位置

${p_t}=({x_t},{y_t})$ 和目标尺寸${s_t}=({w_t},{h_t})$ For n=1, 2, …, n, do:

if n=1:

1.1 裁剪目标小块区域z,利用主干网络提取目标的深度特征

${f_{\theta} }(z)$ ;1.2 根据公式(4)对

${f_{\theta} }(z)$ 进行相关滤波调制,并初始化目标模板${{w}}{\rm{=}}{{{w}}_0}$ ;if n>1:

2.1 以上一帧目标中心位置裁剪第n帧的搜索区域,提取搜索区域的特征

${f_{\theta} }(x)$ ;2.2 将

${{w}}$ 与${f_{\theta} }(x)$ 进行相关运算,相关结果输入到区域建议网络,通过非极大值抑制得到多个候选目标;2.3 利用RoI pooing层提取候选目标固定尺度的特征

${\rm{\{ }}{{{c}}_i}{\rm{\} }}$ ;2.4

${f_{\theta} }(z)$ 通过卷积运算调整尺度大小得到映射矩阵${f_\varphi }(z)$ ,${f_\varphi }(z)$ 与${\rm{\{ }}{{{c}}_i}{\rm{\} }}$ 进行相似性度量得到最终目标估计,对应的特征${{{c}}_t}$ 依照公式 (9)进行相关调制后用于目标框回归;2.5 根据跟踪结果裁剪

${f_{\theta} }(x)$ 对应的目标区域,并计算当前帧的模板${{{w}}_n}$ ,根据公式(5)对模板${{w}}$ 进行更新;Until视频序列结束

-

主干网络采用改进后的ResNet50网络,提取第3个残差模块的特征,先在ImageNet数据集上预训练,再采用迁移学习的方式利用GOK-10k、YouTube-BB数据集进行微调。区域建议网络和验证网络采用交替训练的方式,训练代数为20代,学习率从10−3~10−5依次递减。模板和搜索区域输入尺寸分别为127×27和255×255。采用随机梯度下降(Stochastic Gradient Descent,SGD)优化算法对网络进行训练,参数更新时的动量m取0.9,权值衰减

$\gamma $ 取0.000 5。网络构建采用PyTorch深度学习框架,实验平台:CPU为Intel Xeon E5-2650@2.20 GHz,GPU为NVIDIA TITAN V。 -

OTB100标准测试集共计100个测试序列,视频平均长度为589帧。根据跟踪的难点问题,对每个视频定义了属性标签,包括:遮挡、旋转、变形、光照变化和尺度改变等。评价指标包括准确率图和成功率图,其中准确率图(Precision Plot)基于中心定位误差(Center Location Error,CLE)对跟踪算法进行评价。CLE定义为跟踪算法预测的目标框中心与标注框中心之间的距离,统计出距离小于一定阈值的图片数目,其占视频总帧数的百分比表示该阈值下的准确率。一般情况下采用阈值为20 pixel对应的准确率作为该项评测准则的具体指标。成功率图(Success Plot)采用重叠率(Intersection Over Union,IOU)作为评价的基准,IoU指的是跟踪算法预测的目标框

${A_t}$ 与标注框${A_{gt}}$ 之间的交并比,即${\phi _t}=|{A_t} \cap {A_{gt}}|/|{A_t} \cup {A_{gt}}|$ 。统计出${\phi _t}$ 大于一定阈值下的跟踪图片数目占视频总帧数的百分比,即为该阈值下的成功率。该评测准则的具体指标为AUC(Area Under Curve),即成功率曲线与横轴围成的面积。OTB100标准测试集包含了29种算法的评价结果,这里将文中算法与排名前9的算法TLD、OAB、CSK、ASLA、Struck、DSST、KCF、SAMF、MEEM,以及开源的跟踪算法MUSTER、SRDCF、SiamFC、CFNet、SiamRPN和ECO进行了对比试验。实验采用OPE(One Pass Evaluation)测试方式,只利用初始帧的目标信息,然后跟踪完整个测试序列,测试结果如图8所示。

从精确度曲线和成功率曲线来看,文中算法的精确度与成功能率比ECO高出了6.4%和4.0%。与原来的基准算法SiamRPN相比提升效果明显,精确度与成功率分别提高了12.3%和9.7%。性能提升的原因主要在于二阶段网络结构设计,SiamRPN简单的将相关响应最高的位置作为跟踪结果,而文中提出的网络首先结合时域信息对易区分的样本进行滤除,再利用区域建议加验证网络的方式对高难度样本进行区分,使网络具有更好的分辨力。

-

VOT标准测试集包含了60个更具挑战性的视频,有自己比较系统的评价体系,采用准确率(Accuracy)、鲁棒性(Robustness)和期望平均重叠率(Expected Average Overlap,EAO) 3项指标对跟踪算法进行评价。Accuracy用来评价跟踪算法的准确度,定义为跟踪过程中有效帧的平均重叠率,即

$\;{\rho _A} = 1/ $ $ { N_{{N_{{\rm{valid}}}}}} \displaystyle\mathop \sum \limits_{i = 1:{N_{{\rm{valid}}}}} {\phi _i}$ ,其中${N_{{\rm{valid}}}}$ 表示为有效帧的数量。Robustness用来评价跟踪算法的稳定性,定义为跟踪失败的次数。EAO指标将所有测试视频的长度考虑其中,其计算方法如下:算法对一个视频进行跟踪,跟踪失败后会进行重新初始化,这样一个视频被分割为不同长度的片段。对于一个长度为${N_S}$ 的片段平均重叠率为${{{\varPhi }}_{{N_s}}} = 1/{N_s} \displaystyle\mathop \sum \limits_{i = 1:{N_s}} {\phi _i}$ ,对多个不同长度的序列进行跟踪,计算视频长度在区间$[{N_{lo}},{N_{hi}}]$ 的期望平均重叠率为${{\hat \varPhi }} = 1/({N_{hi}} - {N_{lo}}) \displaystyle\mathop \sum \limits_{{N_s} = {N_{lo}}:{N_{hi}}} {{{\varPhi }}_{{N_s}}}$ 。测试方式分为基本测试和非监督测试,不同之处在于在基本测试条件下,当跟踪失败后,会重新用标注框对跟踪器进行初始化。图9为AR得分,综合了精确度与鲁棒性两项指标对算法进行排序,越靠右上表示性能越好。图10为非监督条件下的重叠率曲线,采用AUC作为算法排名的评价指标。从表1的测试集评价结果(评价指标包括基本测试条件下的精确度、鲁棒性,预期平均重叠率以及非监督条件下的平均重叠率、速度)来看,在基本测试条件下,所提算法的A/R得分为0.601 1/14.515 9,与一阶段孪生网络SiamRPN相比,在鲁棒性方面的性能提升更加明显,结合前面的理论分析可知文中从多方面提高孪生网络对各种干扰的辨别能力,使得失败次数大大下降。EAO与AUC指标分别比排名第2的LADCF和DLSTpp提高了0.6%、3.6%,说明算法在非监督测试条件的优势体现得更为明显。由于采用更复杂的网络,跟踪速度为20.2451FPS,比SiamRPN有所下降,但仍然优于排名靠前的LADCF、MFT算法。

Baseline Unsupervised A-R rank EAO Overlap Speed Overlap Failures EAO AUC Normalized FPS Ours 0.601 1 14.515 9 0.383 3 0.533 9 3.496 1 20.245 1 LADCF 0.491 1 9.925 3 0.3811 0.418 2 0.123 0 0.557 3 MFT 0.491 9 10.766 2 0.379 4 0.391 7 0.194 5 0.623 2 DaSiamRPN 0.569 1 18.441 5 0.378 5 0.468 4 17.818 3 64.414 3 UPDT 0.515 4 11.417 2 0.371 9 0.444 4 0.088 4 0.469 7 RCO 0.498 9 10.700 4 0.371 1 0.383 0 0.204 6 0.720 3 SiamRPN 0.591 5 19.632 5 0.369 1 0.456 8 20.342 6 86.784 3 DRT 0.495 8 13.947 6 0.349 0 0.419 1 0.123 7 0.456 8 DeepSTRCF 0.506 2 14.548 6 0.338 3 0.433 3 0.560 5 3.114 4 CPT 0.488 8 16.620 7 0.332 1 0.375 7 0.877 1 5.184 2 SA_Siam_R 0.544 4 16.403 0 0.331 1 0.425 0 6.776 1 32.364 4 DLSTpp 0.529 7 14.937 4 0.321 3 0.497 8 1.293 0 8.175 9 Table 1. Evaluation results on the VOT benchmark

-

为了进一步测试文中算法性能,采用无人机航拍数据集UAV123对算法进行了测试。数据集使用专业级无人机(DJI S1000)进行拍摄,相机固定在可控框架系统(DJI Zenmuse Z15)上,跟踪高度在5~25 m之间。相机采用焦距为12 mm的松下GH4,视频序列以30~96帧/s的帧速和720 p~4 k的分辨率记录。UAV123数据集包含123个视频序列,总帧数达110 000帧,属于长时间跟踪数据集。跟踪目标包括汽车、卡车、船只、人和空中无人机,以顶视角的方式进行拍摄。在该数据集中的评价采用了同OTB100测试集一样的评价标准,利用精确度图和成功率图对算法性能进行分析。

无人机数据集与OTB数据集相比,面临的情况更加复杂,跟踪视频的长度普遍较长,相机晃动以及目标频繁移出视野对目标跟踪带来了更大挑战。从图11的评测结果来看,SiamRPN因为对目标形变具有较好的适应能力,在长时间跟踪数据集上的性能要优于ECO算法,这与在OTB测试集上的评分正好相反。文中算法与SiamRPN相比准确度与成功率分别提高了5.4%和7.4%,在没有采用长时间跟踪策略的情况下,得益于两阶段跟踪网络更准确的分类和更高的回归精度,文中方法在无人机航拍数据集上也有很好的表现。

-

为了对算法的性能有个定性的分析,列举了10种算法针对多种跟踪场景的对比结果,这些跟踪场景包含多种挑战性因素:剧烈形变、相似干扰物交叉影响、目标遮挡、背景干扰等,如图12所示(OTB-Diving、OTB-Skating2、UAV123-bike2、UAV123-group1),在序列OTB-Diving中,运动员身体完全变形且具有较快的运动速度,这时候基于区域建议的SiamRPN与文中方法的优势体现出来,能较好的适应目标形变,同时文中方法采用两次目标框回归,回归精度有了进步的提升。在序列OTB-Skating2中,被跟踪目标男运动员与干扰物属于同一类别,且频繁交叉遮挡造成干扰,SiamRPN由于缺乏区分同类目标的能力,常常错误将女运动员作为跟踪结果。而文中方法经过RPN阶段相关滤波调制减少错误样本和第二阶段验证网络更加精准分类,具有更好的鲁棒性。相类似情况还有序列UAV123-group1,在目标与干扰物相互干扰的过程中,文中方法都能准确的跟踪目标。在序列UAV123-bike2小目标的跟踪过程中,目标存在多次遮挡的情况,其他算法最后都跟丢目标。得益于强的分辨本领,文中方法在抗遮挡方面也有很好的表现。在无人机空对地的跟踪场景中,相似干扰与频繁遮挡是需要解决的主要挑战,文中方法在该方面体现出了更好的适用性。

两阶段孪生网络性能的提升主要来源于两方面:一方面是通过相关滤波调制以及验证网络相似性度量提升了网络的分类能力;另一方面通过两次目标框回归,回归的准确性也进步提高。图13显示了最终网络对区域建议结果的分类得分,可以看出,算法对错误采样以及相似性目标有很好的区分度,成功地解决了原SiamRPN网络无法处理相似目标干扰的问题。

图14为改进网络回归精度的对比,从图中可以看出,通过两次目标框回归,跟踪精度有了更进一步的提升。例如在序列UAV123-car1跟踪到第401帧的时候,另外一辆汽车由于靠得太近,原SiamRPN算法将黑色车辆也包围进了跟踪框,而两阶段网络能够准确识别目标与干扰。另外,在对小尺度目标(序列UAV123-uav3)、非整体目标(序列UAV123-bike1)的测试也体现了两阶段网络的优势。

图15为各模块运行时间的对比,测试序列为UAV123-car1,采用GPU加速,硬件参数见第2.1节。从图中可以看到,特征提取模块占用了大部分的计算资源,第二阶段验证网络的运行时间比区域建议模块稍长。在有GPU加速的情况下,两阶段孪生网络依然能达到实时。在无人机平台等嵌入式设备不具备GPU运行条件下,需依靠地面端通过数据链传输的方式来实现。

-

文中在孪生网络的基础上,提出了一种基于孪生网络的两阶段跟踪方法。在RPN阶段,通过相关滤波调制和锚点结构设计,得到初步的目标候选框,获取的候选框经感兴趣池化层提取特征后输入到验证网络进行更精准化的分类和回归。相对于一阶段SiamRPN孪生网络,文中方法较好的解决了原来算法无法兼顾泛化能力与抗干扰性的问题,相关滤波调制加上两次目标框回归使模型具有更好的精确度。在多个标准测试集上的评测表明,文中方法在保证较快跟踪速度的前提下,跟踪精度与区分相似干扰物的能力大大提升。由于缺少长时间跟踪策略,模型在跟踪失败后无法对全图进行目标搜索,值得更进一步的研究。

Two-stage object tracking method based on Siamese neural network

doi: 10.3788/IRLA20200491

- Received Date: 2020-12-10

- Rev Recd Date: 2021-02-10

- Publish Date: 2021-09-23

-

Key words:

- neural networks /

- visual tracking /

- region proposal /

- correlation filter

Abstract: Through the introduction of deep learning, the accuracy and robustness of object tracking have been greatly improved. Siamese network based trackers can deal with various deformation of target through training on large-scale datasets, but that makes it difficult to eliminate the interference of similar targets. Therefore, a two-stage tracking method based on Siamese network was proposed. Firstly, the modified residual network was used to extract the deep feature with better performance. Through integrating the temporal information, the template of the region proposal network was adaptively updated through correlation filter modulation, so as to filter out the easily distinguished negative samples. Then, the fixed scale features of candidate regions were extracted by the region-of-interest pooling and fed to the verification network for more refined classification and regression. In order to improve the network's ability to discriminate difficultly distinguished samples, joined training method combining the positive and negative samples was adopted to improve the performance of feature matching. The performance of the proposed method was evaluated on the OTB100, VOT standard benchmarks and the UAV123 aerial benchmark. The experimental results demonstrate that the proposed method can significantly improve the performance of the baseline.

DownLoad:

DownLoad: