-

合成孔径雷达(Synthetic aperture radar,SAR)目标分类技术自20世纪90年代开展研究以来,涌现了大量的研究成果[1]。早期,SAR目标分类方法多以单视角图像为输入,通过适当的特征提取和分类器设计判定目标类别[2-11]。随着SAR数据获取能力的不断增强,基于多视角的SAR目标分类方法也得以广泛研究。考虑到SAR图像的视角敏感性[12],多视角SAR图像的运用能够综合来自不同方位或俯仰角下的SAR图像的鉴别力从而提高分类决策的稳健性。相比传统基于单一视角的SAR目标分类方法,多视角方法通过信息互补能够更为有效地提升整体分类性能。参考文献[13]基于并行决策融合的思路进行多方位角SAR图像决策融合。首先采用支持向量机分别进行单个视角的决策,最后基于投票机制融合不同视角的决策结果。参考文献[14-15]将联合稀疏表示应用于多视角SAR图像的目标分类中,通过联合稀疏表示模型考察不同视角之间的内在关联性从而提高分类精度。参考文献[16-17]认为参与决策融合的多视角中可能存在冗余信息,因此在联合稀疏表示之前预先进行了筛选,通过稀疏表示分类定义判决变量选取若干视角代入后续联合表征。参考文献[18]则进一步对多视角进行分集考察,将内在相关性较强的部分视角归为一个集合。最后,通过各个视角集合的分别稀疏表示和决策融合进行目标分类。

如参考文献[16-18]所论述,实际过程初次选取的多视角可能存在冗余甚至不利于正确分类的信息,有必要进行适当的视角筛选。为此,文中提出基于最大熵准则的多视角SAR图像筛选方法进而应用于目标分类。首先,基于图像相关定义两幅不同视角SAR图像之间的相关度。在此基础上,构造初次选取的多视角之间的相关系数矩阵,反映不同视角之间的内在相关性。分别选取原始多视角SAR图像的子集并计算它们的非线性相关信息熵[19-21]。该熵值代表了选取视角的相关性。因此,对多视角SAR图像进行内在相关性分析,获取具有最大熵的视角集合可有效完成多视角筛选。最后,以联合稀疏表示为基础对多个视角进行联合表征,并计算在不同类别上的总体重构误差,按照最小误差的原则判定测试多视角的目标类别。实验在MSTAR数据集上进行,经多种条件下的分析及比较,结果能够反映方法的有效性。

-

SAR图像具有较强的视角敏感性[12]。随着两幅SAR图像的成像方位角差距逐渐增大,两者的相似度不断降低。然而,在当前的多视角SAR目标分类方法中,一个重要的特性就是运用不同视角之间的内在关联。因此,有必要科学定义不同视角SAR图像之间的相关性。文中采用经典的图像相关作为评价不同视角相关性的基本准则,如公式(1)所示:

式中:

${I_1}$ 和${I_2}$ 代表来自不同方位角的两幅SAR图像;${m_1}$ 和${m_2}$ 分别为它们的像素灰度均值;$\Delta k$ 和$\Delta l$ 为偏置距离,调节它们可获得不同匹配位置上的相似度。公式(1)定义的图像相似度即是寻找不同偏移条件下的最大相似度值。基于公式(1)定义的相似度准则可分别计算多视角SAR图像之间的两两相关性,综合分析可获得多视角之间的内在相关性。为有效利用原始多视角中的稳定内在相关性,提升表征精度以及后续的分类精度,有必要对其中的部分视角进行选取。选取的视角具有较强的、稳定的内在关联,可以更为有效地支撑后续的分类。

-

文中设计基于最大熵值原则对多视角SAR图像进行可靠筛选[21],首先构造不同视角之间的相关系数矩阵如下:

式中:

$E$ 表示单位矩阵;$\tilde R$ 表示$N$ 个视角SAR图像之间的互相关矩阵,其中${\rm{ }}{r_{ij}}$ 表示第i和第j个视角之间的相似度。计算矩阵$R$ 的特征值${\lambda _t}$ ,在此基础上定义非线性相关信息熵${H_R}$ 如下:根据公式(3),当各个视角之间完全独立,即相似度为0,此时相关系数矩阵为单位阵,最终

$R$ 的所有的特征值均为1。此时,熵值最小,为0。当不同视角之间存在一定相关性,即存在非零的相似度,此时$R$ 的特征值不再相等。当不同视角完全匹配(理想状态),熵值为最大值1。因此,根据熵值的大小可以分析多视角SAR图像之间的内在关联。文中采用公式(3)定义的非线性相关信息熵进行最佳视角组合的筛选。对于候选的

$M$ 个不同视角SAR图像,按预定规则对它们进行组合,获得$P$ 个不同的视角子集。然后,对于不同组合的视角子集,采用公式(3)分别计算非线性相关信息熵,然后按照最大熵的原则筛选得到最佳的多个视角。选取得到的多视角具有较强的内在相关性,可充分用于后续的多视角分类算法。 -

根据最大熵值选取得到的多视角SAR图像,文中采用联合稀疏表示对它们进行表征和分析[6, 11-14]。对于待分类的目标

$y$ ,假设选取获得$K$ 个不同视角,记为:$\left[ {{y^{(1)}}{\rm{ }}{y^{(2)}}{\rm{ }} \cdots {\rm{ }}{y^{(K)}}} \right]$ ,联合表示的基本思想是最小化各个视角的整体误差:式中:

$D$ 为全局字典,包含不同训练类别的样本;${\alpha ^{(k)}}$ 对应第$k$ 个视角的表示系数;$\;\beta = \left[ {{\alpha ^{(1)}}{\rm{ }}{\alpha ^{(2)}}{\rm{ }} \cdots {\rm{ }}{\alpha ^{(K)}}} \right]$ 记为系数矩阵。进一步,联合稀疏表示模型引入

${\ell _{\rm{1}}}/{\ell _2}$ 范数分析不同视角之间的关联性,可表示为:通过

${\ell _{\rm{1}}}/{\ell _2}$ 范数对系数矩阵的约束,不同视角对应的系数矢量倾向于相近的分布特性,反映了它们的相关性。对于公式(5)的优化问题,可利用现有联合稀疏表示模型相关算法进行求解。在求解获得不同视角对应的结果的基础上,分类别求解重构误差,如公式(6)所示,最终根据最小误差完成类别决策。

式中:

${D_i}$ 为全局字典$D$ 第$i$ 类的局部字典,即包含第$i$ 类的所有训练样本。 -

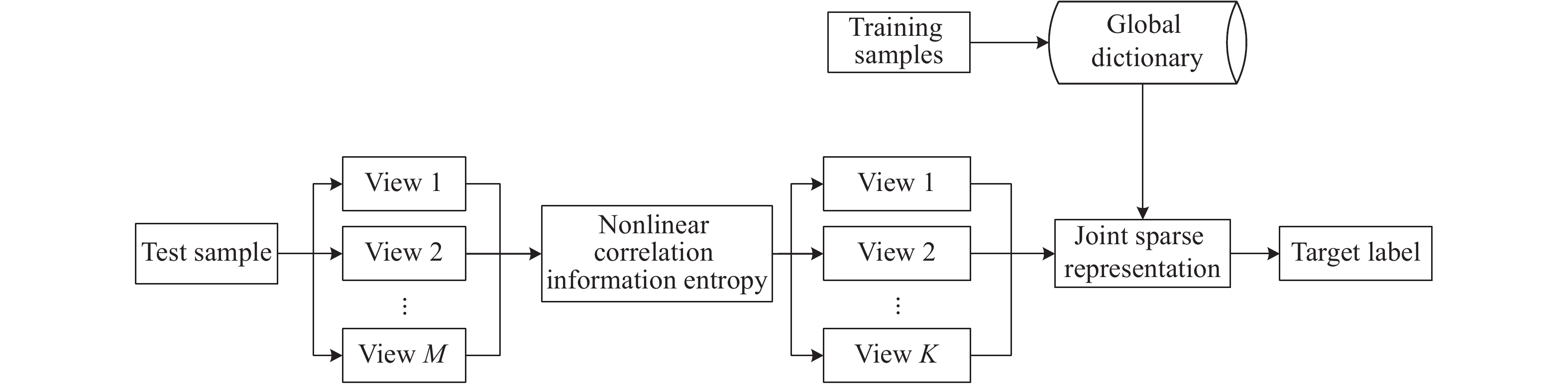

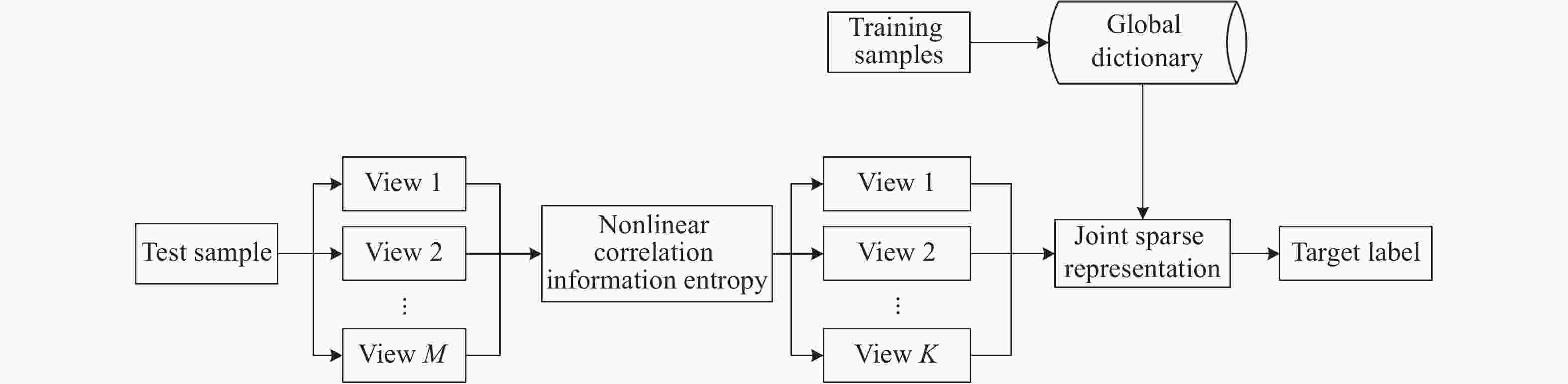

按照上述步骤,分类方法的具体流程如图1所示。对于参与分类的多视角SAR图像,首先基于最大熵值的原则获得最佳的视角子集。然后,通过联合稀疏表示对它们进行表征分析,计算得到不同训练类别对于选取多视角的重构误差。最终,按照最小误差原则获得分类结果,即多视角测试样本的所属目标类别。与传统采用多视角的SAR目标分类方法相比较,文中方法的核心环节在于对原始多视角的选取上。非线性相关信息熵为多视角的筛选提供了定量的评价指标,基于其选取得到的多视角具有较强的内在关联性,有利于后续联合稀疏表示的运用。具体实施中,文中在多视角的初始组合时,要求视角数目不小于3,然后随机组合得到多个视角子集。基于最大熵原则得到最佳的视角子集,代入后续的分类。

-

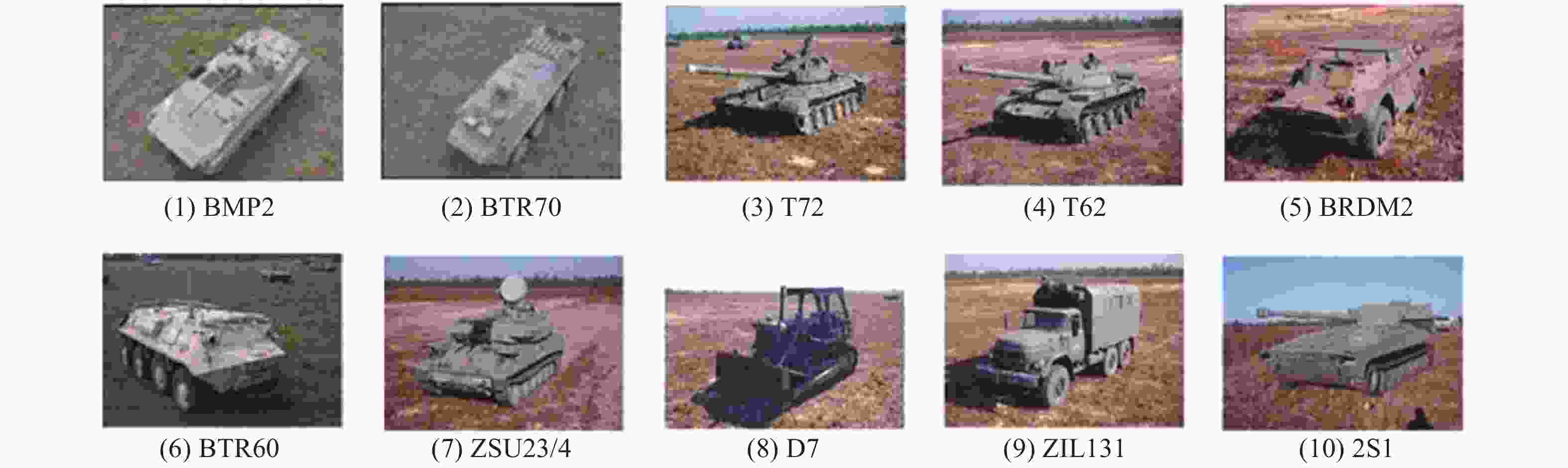

文中基于MSTAR数据集对提出方法进行测试。该数据集采集了X波段下多类地面车辆目标的SAR图像,分辨率可到0.3 m,具备区分战术目标的能力。图2所示为该公开数据集中最为常用的十类目标的光学图像,对应的SAR图像覆盖完整的方位角和部分典型俯仰角。此外,部分目标还采集了多个不同型号的SAR图像,进一步丰富了可用的实验场景。文中在该数据集的基础上设置多种场景对提出方法进行测试,全面考察其分类性能。

在进行文中方法实验的同时,同步与现有方法进行对比,分别取自参考文献[13],参考文献[14]和参考文献[16],分别简记为多视角方法1(Multi-view 1),多视角方法2(Multi-view 2)和多视角方法3(Multi-view 3)。此外,文中还选用当下最为流行的深度学习方法进行对比,即参考文献[10]中基于CNN的方法,该方法直接基于单视角SAR图像进行分类。后续实验基于MSTAR数据样本,进行测试条件设置,并在典型情况下进行比较分析。

-

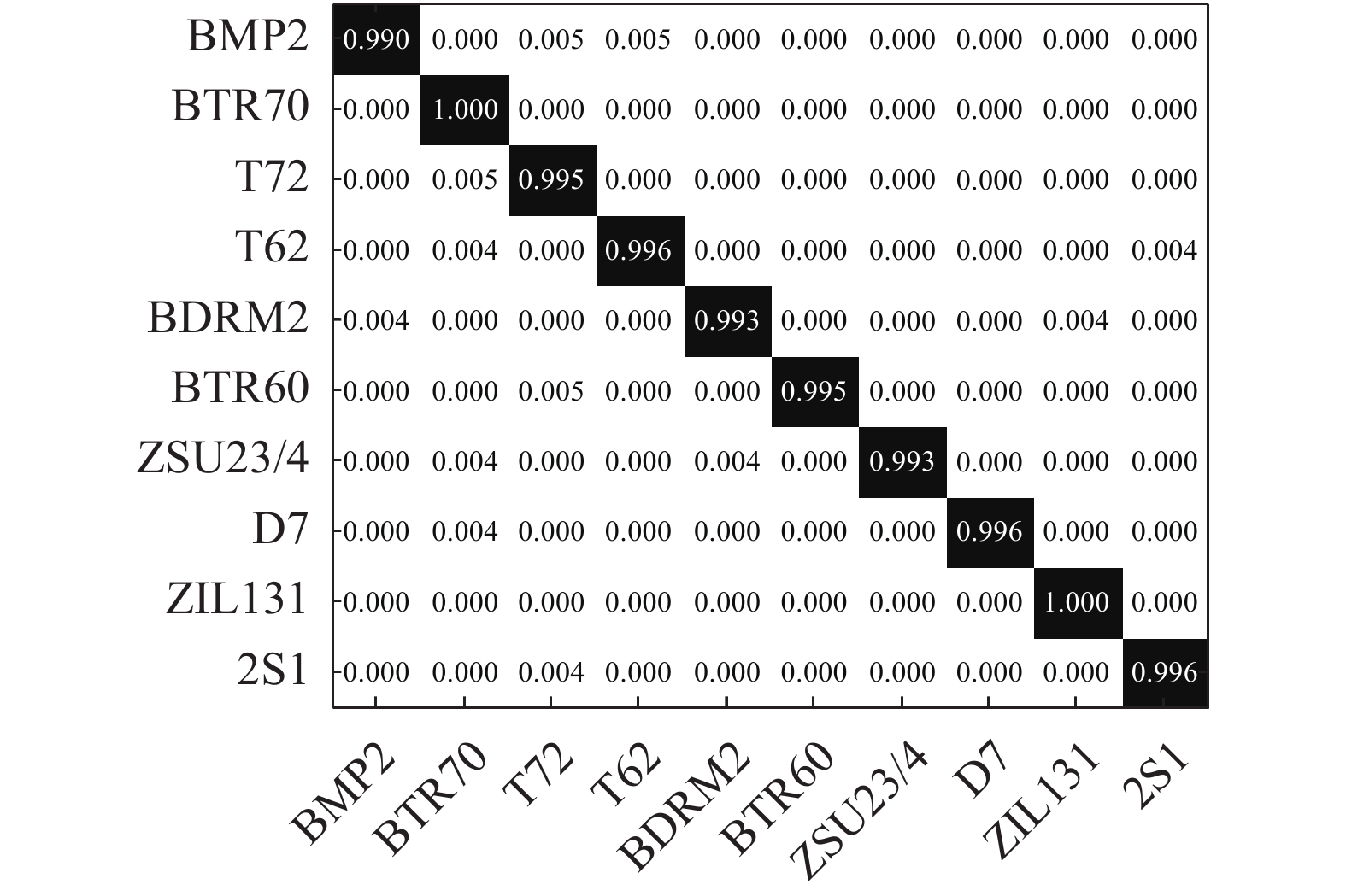

标准操作条件(Standard operating conditions,SOC)的训练和测试集设置如表1所示。其中,训练和测试样本分别取自17°和15°俯仰角,差异较小。两者包含的各类目标具有完全相同的型号,图像相关性较强,分类问题相对简单。该条件下文中方法的分类结果如图3所示。其中,横纵坐标标准目标类别,对角线为相应的正确分类率。可以看出,各类目标的分类性能均达到98%以上,表明方法在标准操作条件下的有效性。对四类对比方法进行同样测试并统计计算它们的分类性能。表2给出了所有方法在标准操作条件下对十类目标的平均分类率。文中方法以99.36%的分类率优于三类对比方法。此外可以发现有两类多视角方法的平均分类率均高于CNN方法,主要是因为多视角互补信息的引入有利于提高决策的稳健性。由于标准操作条件下训练样本可有效描述测试样本的图像特性,训练得到的CNN对于测试样本具有很好的适应性,因此其在单视角的条件下也可以取得高于99%的分类率。

Type Training set Test set BMP2 231 193 BTR70 231 194 T72 230 194 T62 297 271 BRDM2 296 272 BTR60 254 193 ZSU23/4 297 272 D7 297 272 ZIL131 297 272 2S1 297 272 Table 1. Setup of samples under SOC

Method Average classification accuracy Proposed 99.36% Multi-view 1 98.74% Multi-view 2 99.13% Multi-view 3 99.21% CNN 99.08% Table 2. Comparison of average classificationrates under SOC

-

设置如表3所示的训练和测试集对提出方法在型号差异条件下的分类性能进行测试。表中共含四类目标,其中BMP2和T72两类存在型号的不同,给分类问题带来一定的挑战。此外,训练集中增加了BDRM2和BTR70两类混淆目标进一步提高分类难度。在此条件下对各类方法进行测试,获得如表4所示的结果。文中方法可取得最高的正确分类率,显示其优势。基于最大非线性相关信息熵筛选得到的多视角子集能够更好地适应型号差异测试样本的分类问题。因此,通过采用这部分视角进行联合表示有利于提高算法对于不同型号样本的分类识别能力。与基于单一视角的CNN方法形变,四类多视角方法均具有更高的分类率,表明联合多视角有利于提升型号差异条件下的分类性能。

BMP2 BDRM2 BTR70 T72 Training set 231 (Sn_9563) 296 231 230 (Sn_132) Test set 424 (Sn_812) 426 (Sn_9566) 0 0 571 (Sn_A04) 427 (Sn_C21) 571 (Sn_A05) 571 (Sn_A07) 565 (Sn_A10) Table 3. Setup of samples for configuration variance

Method Average classification accuracy Proposed 98.86% Multi-view 1 96.78% Multi-view 2 97.92% Multi-view 3 98.17% CNN 96.02% Table 4. Comparison of average classification rates under configuration variance

-

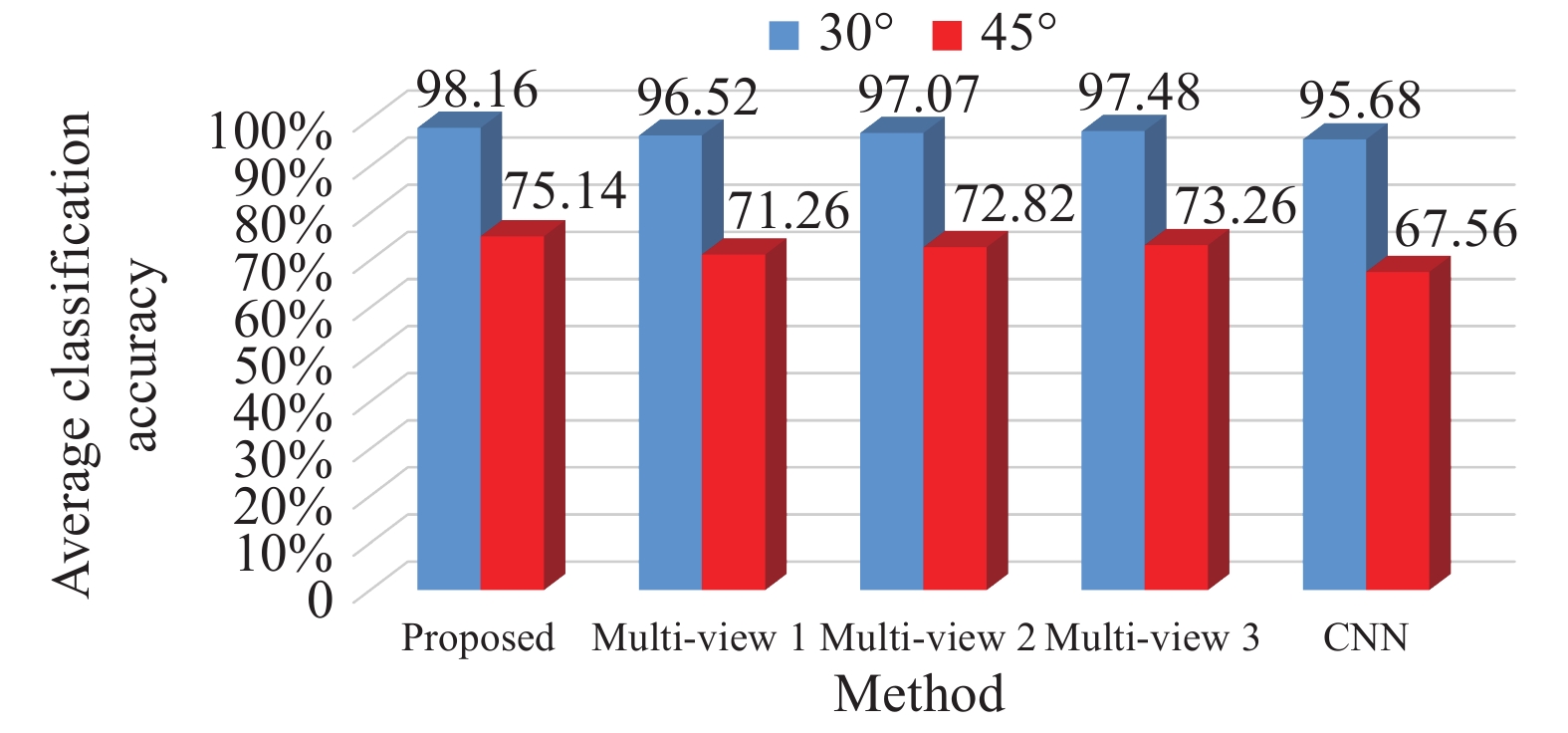

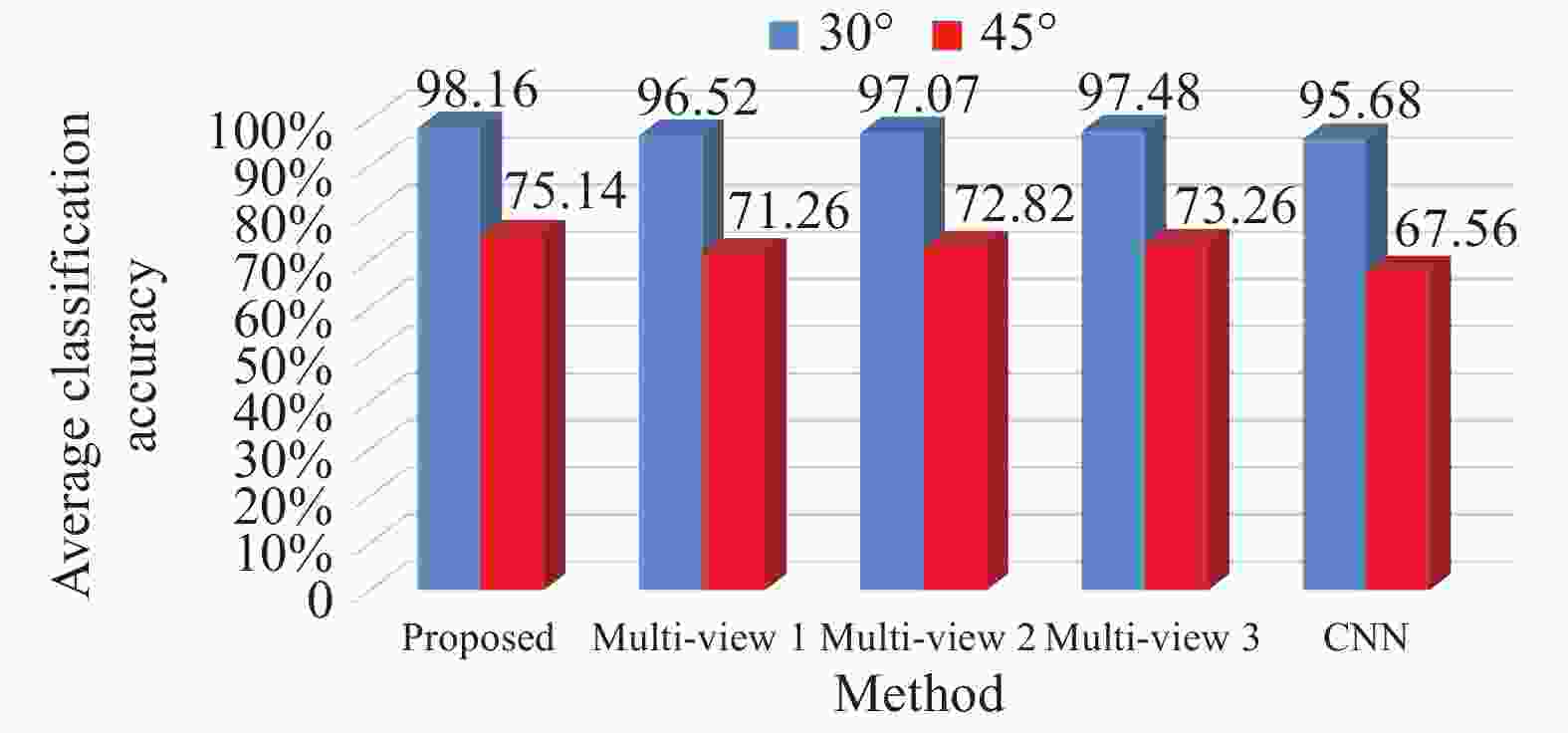

设置如表5所示的训练和测试样本测试方法对于存在俯仰角差异样本的分类识别能力。训练和测试样本共同包含了3类目标的3个不同俯仰角,其中17°用于训练,30°和45°用于测试分类。由于SAR图像具有较强的视角敏感性,较大俯仰角差异带来的图像变化(相对于测试样本)大大增加了分类问题的难度。图4直观显示了两个俯仰角差异情况下各类方法的平均分类率。可见,文中方法对于不同俯仰角的差异样本具有分类有效性。从原理上来说,基于最大熵原则获得的多视角SAR图像对于俯仰角差异的情况具有更强的针对性。在利用这部分视角进行联合分析时可以获得更为可靠的决策结果。同样,俯仰角差异条件下,多视角方法的分类性能优于基于单一视角的CNN方法。

Depression angle/(°) 2S1 BDRM2 ZSU23/4 Training set 17 297 296 297 Test set 30 286 285 286 45 301 301 301 Table 5. Setup of samples under depression angle variance

-

噪声干扰时图像处理领域必须考虑的问题,考察SAR目标分类方法对于噪声干扰的稳健性十分必要。在表1列出的训练和测试样本的基础上,对测试样本进行噪声添加处理,生成不同噪声水平(利用信噪比(SNR)表征)的测试集。据此,可对文中方法以及对比方法在噪声影响条件下的分类性能进行测试[7]。图5所示为各类方法在噪声干扰条件下的分类性能。伴随噪声干扰的加剧,即信噪比的降低,各方法均表现出性能下降。经对比,文中方法的分类率下降最为平缓,且在各个信噪比下均取得了最高的平均分类率,充分表明文中方法对噪声干扰具有更强的稳健性。通过最大熵筛选得到的多视角有效剔除了部分受到噪声严重污染的视角,保证了后续联合稀疏表示中的多视角内在关联性。因此,文中方法可以更为有效地克服噪声干扰下的SAR目标分类难题。

-

文中基于非线性相关信息熵进行多视角SAR图像的筛选进而用于目标分类。采用图像相关度量不同视角SAR图像之间的相似性,构建多视角SAR图像的相关性矩阵。基于非线性相关信息熵获得最优的视角子集。该子集中的SAR图像具有较强的内在相关性。最后,对于选取得到的多视角SAR图像采用联合稀疏表示进行描述和分析,并通过比较不同类别的重构误差进行决策。实验以MSTAR数据集中的SAR图像样本进行条件设置,将文中方法与现有方法进行比较分析。根据结果,文中方法对于标准操作条件,型号差异、俯仰角变化以及噪声影响样本均表现出更为优越的性能,验证其有效性。

Multi-view SAR target classification method based on principle of maximum entropy

doi: 10.3788/IRLA20210233

- Received Date: 2021-05-25

- Rev Recd Date: 2021-06-30

- Publish Date: 2021-12-31

-

Key words:

- synthetic aperture radar /

- target classification /

- multiple views /

- nonlinear correlation information entropy /

- joint sparse representation

Abstract: For the synthetic aperture radar (SAR) target classification method, a multi-view was developed based on the principle of the maximum entropy. The mutual-correlation matrix between multi-view SAR images was established based on the classical image correlation. Afterwards, the nonlinear correlation information entropy (NCIE) of different view sets was calculated. NCIE is capable of analyzing the statical properties of multiple variables and entropy value reflects the inner correlation of different variables. The view set with the highest nonlinear correlation information entropy was chosen, in which the multiple views share the highest correlation. The joint sparse representation was employed to represent the selected multi-view SAR images and the target label was determined based on the total reconstruction errors. The joint sparse representation is capable of handling several sparse representation problems and enhancing the reconstruction precision when these problems share some correlations. The proposed method could effectively analyze the inner correlations of multiple views and employ joint sparse representation to exploit such correlations so the classification accuracy can be improved. Typical experimental setups were designed based on the MSTAR dataset to test the performance of the proposed method while compared with some other methods under different test conditions. The results show the validity of the principle of the maximum entropy and the superior performance of the proposed method for SAR target classification.

DownLoad:

DownLoad: